ТРАНСФОРМАТОРЫ. РАСШИФРОВКА НАИМЕНОВАНИЙ

Наименование (а точнее, номенклатура) трансформатора, говорит о его конструктивных особенностях и параметрах. При умении читать наименование оборудования можно только по нему узнать количество обмоток и фаз силового трансформатора, тип охлаждения, номинальную мощность и напряжение высшей обмотки.

ОБЩИЕ РЕКОМЕНДАЦИИНоменклатура трансформаторов (расшифровка буквенных и цифровых обозначений наименования) не регламентируется какими-либо нормативными документами, а всецело определяется производителем оборудования. Поэтому, если название Вашего трансформатора не поддаётся расшифровке, то обратитесь к его производителю или посмотрите паспорт изделия. Приведенные ниже расшифровки букв и цифр названия трансформаторов актуальны для отечественных изделий.

Наименование трансформатора состоит из букв и цифр, каждая из которых имеет своё значение. При расшифровке наименования следует учитывать то что некоторые из них могут отсутствовать в нём вообще (например буква «А» в наименовании обычного трансформатора), а другие являются взаимоисключающими (например, буквы «О» и «Т»).

Для силовых трансформаторов приняты следующие буквенные обозначения:

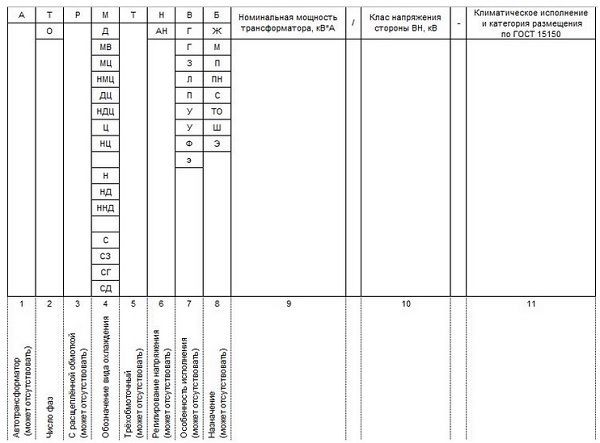

Таблица 1 — Расшифровка буквенных и цифровых обозначений наименования силового трансформатора

Примечание: принудительная циркуляция воздуха называется дутьем, то есть «с принудительной циркуляцией воздуха» и «с дутьем» равнозначные выражения.

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ СИЛОВЫХ ТРАНСФОРМАТОРОВ

ТМ — 100/35 — трансформатор трёхфазный масляный с естественной циркуляцией воздуха и масла, номинальной мощностью 0,1 МВА, классом напряжения 35 кВ;

ТДНС — 10000/35 — трансформатор трёхфазный с дутьем масла, регулируемый под нагрузкой для собственных нужд электростанции, номинальной мощностью 10 МВА, классом напряжения 35 кВ;

ТРДНФ — 25000/110 — трансформатор трёхфазный, с расщеплённой обмоткой, масляный с принудительной циркуляцией воздуха, регулируемый под нагрузкой, с расширителем, номинальной мощностью 25 МВА, классом напряжения 110 кВ;

АТДЦТН — 63000/220/110 — автотрансформатор трёхфазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 63 МВА, класс ВН — 220 кВ, класс СН — 110 кВ;

АОДЦТН — 333000/750/330 — автотрансформатор однофазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 333 МВА, класс ВН — 750 кВ, класс СН — 500 кВ.

Для регулировочных трансформаторов приняты следующие сокращения:

Таблица 2 — Расшифровка буквенных и цифровых обозначений наименования регулировочного трансформатора

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ РЕГУЛИРОВОЧНЫХ ТРАНСФОРМАТОРОВ

ВРТДНУ — 180000/35/35 — трансформатор вольтодобавочный, регулировочный, трёхфазный, с масляным охлаждением типа Д, регулируемый под нагрузкой, с усиленным вводом, проходной мощностью 180 МВА, номинальное напряжение обмотки возбуждения 35 кВ, номинальное напряжения регулировочной обмотки 35 кВ;

ЛТМН — 160000/10 — трансформатор линейный, трёхфазный, с естественной циркуляцией масла и воздуха, регулируемый под нагрузкой, проходной мощностью 160 МВА, номинальным линейным напряжением 10 кВ.

РАСШИФРОВКА НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ НАПРЯЖЕНИЯ

Для трансформаторов напряжения приняты следующие сокращения:

Таблица 3 — Расшифровка буквенных и цифровых обозначений наименования трансформатора напряжения

Примечание:

Комплектующий для серии НОСК;

С компенсационной обмоткой для серии НТМК;

Кроме серии НОЛ и ЗНОЛ, в которых:

— 06 — для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки;

— 08 — для ЗРУ и КРУ внутренней и наружной установки;

— 11 — для взрывоопасных КРУ.

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ НАПРЯЖЕНИЯ

НОСК-3-У5 — трансформатор напряжения однофазный с сухой изоляцией, комплектующий, номинальное напряжение обмотки ВН 3 кВ, климатическое исполнение — У5;

НОМ-15-77У1 — трансформатор напряжения однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1977 года разработки, климатическое исполнение — У1;

ЗНОМ-15-63У2 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1963 года разработки, климатическое исполнение — У2;

ЗНОЛ-06-6У3 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с литой эпоксидной изоляцией, для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки, климатическое исполнение — У3;

НТС-05-УХЛ4 — трансформатор напряжения трёхфазный с сухой изоляцией, номинальное напряжение обмотки ВН 0,5 кВ, климатическое исполнение — УХЛ4;

НТМК-10-71У3 — трансформатор напряжения трёхфазный с масляной изоляцией и компенсационной обмоткой, номинальное напряжение обмотки ВН 10 кВ, 1971 года разработки, климатическое исполнение — У3;

НТМИ-10-66У3 — трансформатор напряжения трёхфазный с масляной изоляцией и обмоткой для контроля изоляции сети, номинальное напряжение обмотки ВН 10 кВ, 1966 года разработки, климатическое исполнение — У3;

НКФ-110-58У1 — трансформатор напряжения каскадный в фарфоровой покрышке, номинальное напряжение обмотки ВН 110 кВ, 1958 года разработки, климатическое исполнение — У1;

НДЕ-500-72У1 — трансформатор напряжения с ёмкостным делителем, номинальное напряжение обмотки ВН 500 кВ, 1972 года разработки, климатическое исполнение — У1;

РАСШИФРОВКА НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ ТОКА

Для трансформаторов тока приняты следующие сокращения:

Таблица 4 — Расшифровка буквенных и цифровых обозначений наименования трансформатора тока

Примечание:

Для серии ТВ, ТВТ, ТВС, ТВУ;

Для серии ТНП, ТНПШ — с подмагничиванием переменным током;

Для серии ТШВ, ТВГ;

Для ТВВГ — 24 — водяное охлаждение;

Для серии ТНП, ТНПШ;

Для серии ТВ, ТВТ, ТВС, ТВУ — номинальное напряжения оборудования;

Для серии ТНП, ТНПШ — число обхватываемых жил кабеля;

Для серии ТНП, ТНПШ — номинальное напряжение.

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ ТОКА

ТФЗМ — 35А — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой звеньевого исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 35 кВ, категории А, климатическим исполнением У1;

ТФРМ — 750М — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой рымочного исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 750 кВ, климатическим исполнением У1;

ТШЛ — 10К — трансформатор тока шинный с литой изоляцией, номинальное напряжением обмотки ВН 10 кВ;

ТЛП — 10К — У3 — трансформатор тока с литой изоляцией, проходной, номинальным напряжением обмотки ВН 10 кВ, климатическое исполнение — У3;

ТПОЛ — 10 — трансформатор тока проходной, одновитковый, с литой изоляцией, номинальным напряжением обмотки ВН 10 кВ;

ТШВ — 15 — трансформатор тока шинный, с воздушным охлаждением, номинальным напряжением обмотки ВН 15 кВ;

ТВГ — 20 — I

ТШЛО — 20 — трансформатор тока шинный, с литой изоляцией, одновитковый, номинальным напряжением обмотки ВН 20 кВ;

ТВ — 35 — 40У2 — трансформатор тока встроенный, номинальным напряжением обмотки ВН 35 кВ, током термической стойкости 40 кА, климатическое исполнение — У2;

ТНП — 12 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, охватывающий 12 жил кабеля;

ТНПШ — 2 — 15 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, шинный, охватывающий 2 жилы кабеля, номинальным напряжением обмотки ВН 15 кВ.

Расшифровка и маркировка обозначений трансформаторов (аббревиатур)

Маркировка трансформаторов

Любой трансформатор отличается различными конструктивными особенностями, областью применения, номинальным напряжением и климатическими условиями и т.п. Нужно уметь правильно расшифровать маркировку буквенно — цифровые обозначения характеристик трансформаторов: его мощность, систему охлаждения, количество обмоток, напряжение на обмотках высшего напряжения и низшего напряжения.

В настоящее время чтобы точно определить номенклатуру трансформатора нужно не только смотреть на название трансформатора, нормативные документы, но сверятся с документацией завода производителя трансформатора. Ниже даны расшифровки трансформаторов отечественного производства.

Любая цифра или буква на табличке набитой на корпусе трансформатора имеет свое значение. Некоторые буквы могут отсутствовать, другие не могут быть одновременно, например «О» и «Т» однофазный и трехфазный.

Самые частые обозначения трансформаторов буквенные: ТМ, ТС, ТСЗ, ТД, ТДЦ, ТМН, ТДН, ТЦ, ТДГ, ТДЦГ, ОЦ, ОДГ, ОДЦГ, АТДЦТНГ, АОТДЦН и т. д

- А – обозначает автотрансформатор

- Первая буква отмечает фазировку: Т — трехфазный, О – однофазный;

- Буква Р (с расщепленной обмоткой) после числа фаз в обозначении указывает, что обмотка низшего напряжения представлена двумя (тремя) обмотками.

- Вторая буква указывает на систему охлаждения: М — естественное масляное, т. е. естественная циркуляция масла, С — сухой трансформатор с естественным воздушным охлаждением открытого исполнения, Д — масляное с дутьем, т. е. с обдуванием бака при помощи вентилятора, Ц — принудительная циркуляция масла через водяной охладитель, ДЦ — принудительная циркуляция масла с дутьем.

- Наличие второй буквы Т означает, что трансформатор трехобмоточный, двухобмоточный специального обозначения не имеет.

- Н — регулирование напряжения под нагрузкой (РПН), отсутствие — наличие переключения без возбуждения (ПБВ),

- Г — грозоупорный.

- За буквенными обозначениями следуют (Uн) номинальная мощность трансформатора (кВА)

- через дробь — класс номинального напряжения обмотки ВН (кВ). В автотрансформаторах добавляют в виде дроби класс напряжения обмотки СН. Иногда указывают год начала выпуска трансформаторов данной конструкции.

Шкала номинальных мощностей трехфазных силовых трансформаторов и автотрансформаторов (действующие государственные стандарты 1967 — 1974 гг.) высоковольтных сетей выстроена так, чтобы были значения мощности, кратные десяти: 20, 25, 40, 63, 100, 160, 250, 400, 630, 1000, 1600 кВА и т. д. Отдельные исключение составляют мощности 32000, 80000, 125000, 200000, 500000 кВА

Срок службы трансформаторов довольно длительные и равен 50 лет. В наше время можно встретить трансформаторы промышленных производств изготовленные еще 1968г, прошедшие капитальный ремонт.

Шкала мощностей трансформаторов выпущенных в СССР: 5, 10, 20, 30, 50, 100, 180, 320, 560, 750, 1000, 1800, 3200, 5600, …, 31500, 40500, кВА и т. д.

д.

Чтобы не запутаться в табличке указанных данных, можно разбить ее шесть групп.

Пример определения показателей для трансформатора АОДЦТН — 333000/750/330

автотрансформатор однофазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 333 МВА, класс ВН — 750 кВ, класс СН — 500 кВ

Расшифровка трансформаторов, примеры

Трансформаторы тока обозначаются следующим образом:

• Т — Буква указывает, что это именно трансформатор тока

• Вторая буква означает конструктивное исполнение: «П» — проходной, «О» – опорный трансформатор, «Ш» -шинный, «Ф» — с фарфоровой покрышкой

• Третье обозначение указывает на изоляцию и систему охлаждения обмоток трансформатора «Л» — литая изоляция, «М» — масляная,

Потом идет через “-“ класс изоляции, климатическое исполнение трансформаторов, и, категория установок.

Пример расшифровки трансформатора тока ТПЛ — 10УХЛ4 100/5А.

- Т – тока

- П – проходной

- Л – литая изоляция

- Класс 10 кВ

- УХ – умеренного и холодного климата

- 4 – четвертая категория

- 100/5А – коэффициент трансформации как сто к пяти.

Примеры расшифровка трансформаторов напряжения:

ТМ — 100/35 — трансформатор трёхфазный масляный с естественной циркуляцией воздуха и масла, номинальной мощностью 0,1 МВА, классом напряжения 35 кВ;

ТДНС — 10000/35 — трансформатор трёхфазный с дутьем масла, регулируемый под нагрузкой для собственных нужд электростанции, номинальной мощностью 10 МВА, классом напряжения 35 кВ;

ВРТДНУ — 180000/35/35 — трансформатор вольтодобавочный, регулировочный, трёхфазный, с масляным охлаждением типа Д, регулируемый под нагрузкой, с усиленным вводом, проходной мощностью 180 МВА, номинальное напряжение обмотки возбуждения 35 кВ, номинальное напряжения регулировочной обмотки 35 кВ;

ЛТМН — 160000/10 — трансформатор линейный, трёхфазный, с естественной циркуляцией масла и воздуха, регулируемый под нагрузкой, проходной мощностью 160 МВА, номинальным линейным напряжением 10 кВ.

НКФ-110-58У1 — трансформатор напряжения каскадный в фарфоровой покрышке, номинальное напряжение обмотки ВН 110 кВ, 1958 года разработки, климатическое исполнение — У1;

НДЕ-500-72У1 — трансформатор напряжения с ёмкостным делителем, номинальное напряжение обмотки ВН 500 кВ, 1972 года разработки, климатическое исполнение — У1;

ТНП — 12 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, охватывающий 12 жил кабеля;

ТНПШ — 2 — 15 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, шинный, охватывающий 2 жилы кабеля, номинальным напряжением обмотки ВН 15 кВ.

Видео: Классификация трансформаторов

Поделиться ссылкой:

Расшифровка трансформаторов: тока, напряжения и силовых

Чтобы понимать, для каких условий эксплуатации предназначен тот или иной трансформатор тока или напряжения, а также прочие разновидности, применяется особая маркировка приборов. Отечественные и импортные агрегаты имеют различное обозначение. В нашей стране чаще применяются установки, изготовленные по ГОСТу.

Маркировка трансформаторов наносится на щиток из металла на корпусе. Самые распространённые виды условных обозначений трансформаторов будут рассмотрены далее.

Информация на корпусе

Информация, представленная на видимой стороне устройства, наносится при помощи гравировки, травления или теснения. Это обеспечивает чёткость и долговечность надписи. На металлическом щитке указываются данные о заводе-изготовителе оборудования. Наносится год его выпуска, заводской номер.

Наносится год его выпуска, заводской номер.

Помимо данных о производителе обязательно присутствует информация об агрегате. Указывается номер стандарта, которому соответствует представленная конструкция. Обязательно наносится показатель номинальной мощности. Для трехфазных устройств этот параметр приводится для каждой обмотки отдельно. Указывается информация о напряжении ответвлений витков катушек.

Для всех обмоток определяется показатель номинального тока. Приводится количество фаз установки, частота тока. Производитель предоставляет данные о конфигурации и группах соединения катушек.

После приведённой выше информации можно ознакомиться с параметрами напряжения короткого замыкания. Представляются требования к установке. Она может быть наружной или внутренней.

Технические характеристики позволяют определить способ охлаждения, массу масла в баке (если применяется эта система), а также массу активной части. На приводе переключателя указывается его положение. Если установка обладает сухим видом охлаждения, есть данные о мощности установки при отключённом вентиляторе.

Если установка обладает сухим видом охлаждения, есть данные о мощности установки при отключённом вентиляторе.

Под щитком должен быть выбит заводской номер. Он присутствует на баке. Номер указывается на крышке возле ввода ВН, а также сверху и слева на полке балки сердечника.

Схема

Все приведённые на табличке данные можно разбить на 6 групп. Чтобы не запутаться в информации, следует рассмотреть последовательность её написания. Например, установка АТДЦТН-125000/220/110/10-У 1. Для маркировки особенностей прибора применяются следующие группы:

- I группа. А — Предназначена для указания типа прибора (силовой или автотрансформатор).

- II группа. Т — Соответствует типу сети, для которой применяется прибор (однофазная, трехфазная).

- III группа. ДЦ – Система охлаждения с принудительной циркуляцией масла и воздуха.

- IV группа. Т – Показывает количество обмоток (трехобмоточный).

- V группа. Н – Напряжение регулируется под нагрузкой.

- VI группа.

Все цифры (номинальная мощность, напряжение ВН СН обмоток, климатическое исполнение, категория размещения).

Все цифры (номинальная мощность, напряжение ВН СН обмоток, климатическое исполнение, категория размещения).

О каждой категории следует узнать подробнее. Это значительно облегчит выбор.

Разновидности

Обозначение трансформаторов обязательно начинается с разновидности оборудования. Если маркировка начинается с буквы А, это автотрансформатор. Её отсутствие говорит о том, что агрегат относится к классу силовых трансформаторов.

Обязательно приводится число фаз. Это позволяет выбрать установку, работающую от бытовой или промышленной сети. Если трансформатор подключается к трехфазной сети, в маркировке будет присутствовать Т. Однофазные же разновидности имеют букву О. Они применяются в бытовых сетях.

Если устройство обладает расщеплённой обмоткой, он будет иметь Р. Если присутствует регулировка напряжения под нагрузкой (РПН) устройство будет иметь маркировку Н на металлическом щитке. При её отсутствии можно сделать вывод об отсутствии представленной особенности в аппарате.

Особые обозначения

В зависимости от категории установки могут применяться особые обозначения. Для трансформатора тока и напряжения они могут не совпадать. Вторая разновидность техники применяется при работе защитных механизмов или для измерения тока. Первая категория приборов предназначается для изменения значения переменного тока.

Трансформаторы напряжения не используют для передачи электричества большой мощности. Они способны создавать развязку от низковольтных коммуникаций. В цепях с напряжением 12В и менее применяется эта категория приборов. Основным их рабочим параметром выступает ток и напряжение первичной обмотки. Именно их величину предоставляет производитель.

Маркировка трансформаторов напряжения начинается с их конструкции. Если это проходная конструкция, она обозначается литерой П. Если её нет, это опорный вид аппаратов. Литой изолятор имеет в маркировке Л, а фарфоровый – Ф. Встроенный изолятор имеет В.

Расшифровка современных трансформаторов тока выполняется в установленной последовательности. Она начинается с Т, которая характеризует представленные приборы. Способ установки может быть проходным (П), опорным (О) или шинным (Ш). Если этот прибор присутствует в аппаратуре силовых трансформаторов, он обозначается как ВТ. Если же он встроен в масляный выключатель, то маркировка будет иметь букву В. При наружной установке прибор будет иметь Н.

Она начинается с Т, которая характеризует представленные приборы. Способ установки может быть проходным (П), опорным (О) или шинным (Ш). Если этот прибор присутствует в аппаратуре силовых трансформаторов, он обозначается как ВТ. Если же он встроен в масляный выключатель, то маркировка будет иметь букву В. При наружной установке прибор будет иметь Н.

Охладительная система

Условное обозначение трансформатора продолжается способом охлаждения. Сегодня существуют сухие, масляные разновидности. Также охладительная установка может иметь в своём составе негорючий текучий диэлектрик.

Масляные разновидности включают в себя около десятка различных конструкций оборудования. Если циркуляция жидкости внутри производится естественным путём, прибор имеет на щитке М. Если же она принудительная, здесь будет присутствовать обозначение Д. Оно соответствует также и сухим разновидностям приборов с представленным устройством внутренней циркуляции.

Если установлено оборудование с естественным движением масла и принудительным течением воды, оно маркируется сочетанием МВ. Для приборов с принудительной циркуляцией ненаправленного потока масла и естественным перемещением воздуха используется комбинация МЦ. Если же в таком устройстве направление масла чётко обозначено, маркировка будет НМЦ.

Для приборов с принудительной циркуляцией ненаправленного потока масла и естественным перемещением воздуха используется комбинация МЦ. Если же в таком устройстве направление масла чётко обозначено, маркировка будет НМЦ.

Для систем с принудительным ненаправленным движением масла и воздуха применяется обозначение ДЦ, а для направленного перемещения – НДЦ. Когда масло движется в пространстве между трубами и перегородками, по которым течёт вода, такой агрегат имеет на щитке букву Ц. Если же масло течёт по направленному вектору, прибор маркируется НЦ.

Охладительная система с жидким диэлектриком

Сегодня в «эксплуатацию» вводят новые разновидности устройств с различными улучшенными охладительными системами. Одной из них являются экземпляры техники с негорючим диэлектриком жидкого типа. Если охлаждение происходит посредством естественной циркуляции, представленная установка обозначается буквой Н. Если же присутствует принудительное движение воздуха, маркировка будет НД.

На табличке агрегатов с направленным потоком жидкого диэлектрика и принудительной циркуляцией воздуха указывается ННД. Это позволяет подобрать правильно тип аппаратуры.

Это позволяет подобрать правильно тип аппаратуры.

Сухие системы

Одной из новых разновидностей являются системы сухого охлаждения. Они просты в эксплуатации и обслуживании, не требовательны и не капризны. Если исполнение установки открытое, а циркуляция воздуха происходит естественным способом, его маркируют как С.

Защищённое исполнение обозначается буквами СЗ. Корпус может быть закрыт от воздействия различных факторов окружающей среды, он называется герметичным. При естественной циркуляции воздуха в нём, маркировка имеет буквы СГ.

В воздушных охладительных системах может присутствовать принудительная циркуляция. В этом случае устройство обозначается буквами СД.

Исполнение

Установки могут отличаться между собой особенностями исполнения. Если в них присутствует принудительная циркуляция воды, это позволит понять присутствующая на корпусе буква В. При наличии защиты от грозы и поражения молнией, конструкция имеет маркировку Г.

Система может обладать естественной циркуляцией масла или негорючего диэлектрика. При этом в некоторых разновидностях используется защита с азотной подушкой. В ней нет расширителей, выводов во фланцах стенок бака. Обозначение имеет букву З.

При этом в некоторых разновидностях используется защита с азотной подушкой. В ней нет расширителей, выводов во фланцах стенок бака. Обозначение имеет букву З.

Литая изоляция обозначается как Л. Подвесное исполнение определяет буква П. Усовершенствованная категория аппаратов обозначается как У. Они могут иметь автоматические РПН.

Оборудование с выводами и расширителем, установленными на фланцах стенках бака, маркируется буквой Ф. Энергосберегающий аппарат имеет пониженные потери энергии на холостом ходу. Его обозначают буквой Э.

Назначение

После категории особенностей исполнения представляется информация о назначении и области применения оборудования. Маркировка с буквой Б говорит о способности конструкции прогревать грунт или бетон зимой. Такое же обозначение может иметь трансформатор, предназначенный для станков буровых.

При электрификации железной дороги нужны установки с особыми свойствами и характеристиками. Они маркируются буквой Ж. Устройства с обозначением М эксплуатируются на металлургических комбинатах.

При передаче постоянного тока по линии нужны конструкции класса П. Агрегаты для обеспечения работы погружных насосов обозначаются как ПН.

Если агрегат применяется для собственных нужд электростанции, он относится к категории С. Тип ТО применяется для обработки грунта и бетона при высокой температуре, обеспечения электроэнергией временного освещения и ручного инструмента.

В угольных шахтах применяют трансформаторы разновидности Ш, а в системе питания электричеством экскаватора – Э.

Цифры

После перечисленных обозначений могут следовать числовые значения. Это номинальное напряжение обмотки в кВ, мощность в кВА. Для автотрансформаторов добавляется информация о напряжении обмотки СН.

В маркировке может присутствовать первый год выпуска представленной конструкции. Мощность агрегатов может составлять 20,40, 63, 160, 630, 1600 кВА и т. д. Этот показатель подбирают в соответствии с эксплуатационными условиями. Существует оборудование более высокой мощности. Этот параметр может достигать 200, 500 МВА.

Этот параметр может достигать 200, 500 МВА.

Продолжительность применения трансформаторов советского производства составляет порядка 50 лет. Поэтому в современных энергетических коммуникациях может применяться оборудование, выпущенное до 1968 г. Их периодически совершенствуют и реконструируют при капитальном ремонте.

Примеры

Чтобы понимать, как трактовать информацию на корпусе аппаратуры, следует рассмотреть несколько примеров маркировок. Это могут быть следующие трансформаторы:

- ТДТН-1600/110. Трехфазный класс техники понижающего типа. Он имеет масляное принудительное охлаждение, а также устройство РПН. Номинальная мощность равняется 1600, а напряжение ВН обмотки – 110 кВ.

- АТДЦТН-120000/500/110-85. Автотрансформатор, который применяется в трехфазной сети. Он имеет три обмотки. Масляная система охлаждения имеет принудительную циркуляцию. Есть устройство РПН. Номинальная мощность составляет 120 МВА. Устройство понижает напряжение и работает между сетями 500 и 110 кВ.

Разработка 1985 года.

Разработка 1985 года. - ТМ-100/10 – двухобмоточный агрегат, который рассчитан для работы в трехфазной сети. Масляная система циркуляции имеет естественное перемещение жидкости. Изменение напряжения происходит при помощи ПБВ узла. Номинальная мощность составляет 100 кВА, а класс обмотки – 10 кВ.

- ТРДНС-25000/35-80. Аппарат для трехфазной сети с двумя расщеплёнными обмотками. Охлаждение производится посредством принудительной циркуляции масла. В конструкции есть регулятор РПН. Применяется для нужд электростанции. Мощность агрегата составляет 25 МВА. Класс напряжения обмотки – 35 кВ. Конструкция разработана в 1980 году.

- ОЦ-350000/500. Двухобмоточное устройство для однофазной сети повышающего класса. Применяется масляное охлаждение при помощи принудительного движения жидкости. Мощность 350 МВА, напряжение обмотки 500 кВ.

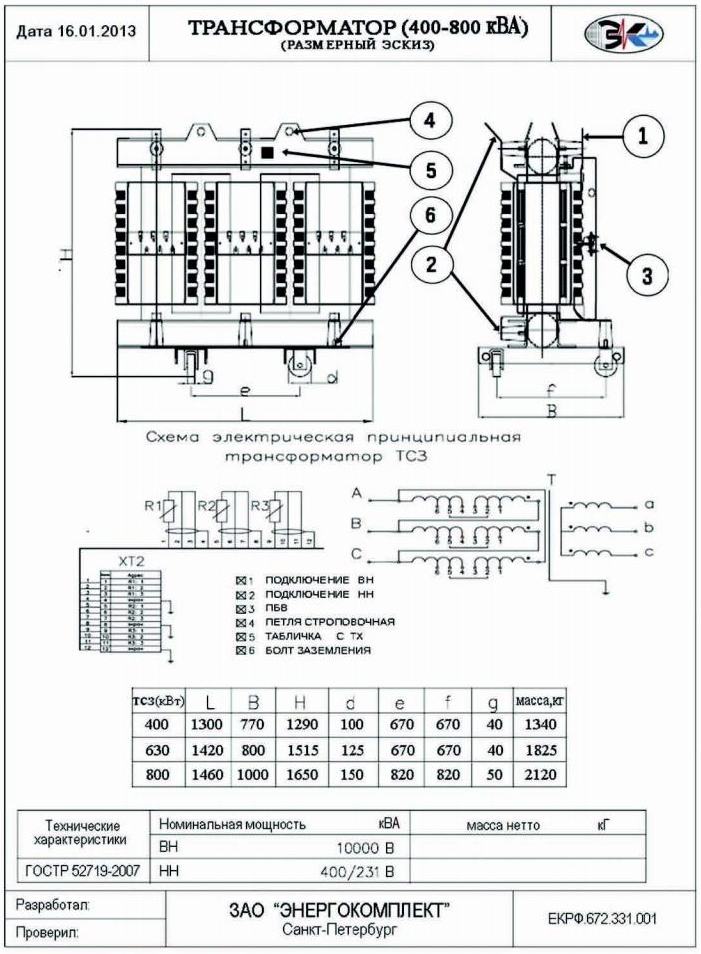

- ТСЗ-250/10-79. Экземпляр для трехфазной сети с сухим способом охлаждения. Корпус защищённый. Мощность составляет 250 кВА, а обмотки – 10 кВ.

Устройство создано в 1979 г.

Устройство создано в 1979 г. - ТДЦТГА-350000/500/110-60. Трехобмоточный прибор для трехфазной сети. Применяется для повышения напряжения. Трансформация происходит по принципу НН-СН и НН-ВН. Конструкция разработана в 1960 году.

Видео: Классификация трансформаторов

Рассмотрев особенности маркировки различных видов трансформаторов, можно правильно применять их на объекте. Знание обозначений позволяет понимать функции, основные технические характеристики подобного оборудования. Маркировка, включающая в себя буквы и цифры, соответствует ГОСТам, применяемым в процессе изготовления специальной техники.

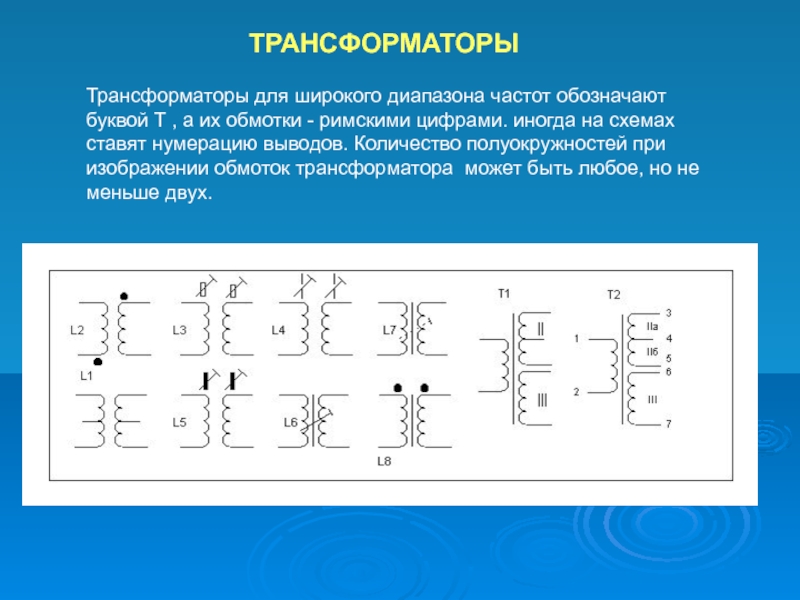

Трансформаторы — Буквенные обозначения трансформатора

БУКВЕННОЕ ОБОЗНАЧЕНИЕ СИЛОВОГО ТРАНСФОРМАТОРА

ОБЩЕГО И СПЕЦИАЛЬНОГО НАЗНАЧЕНИЯ

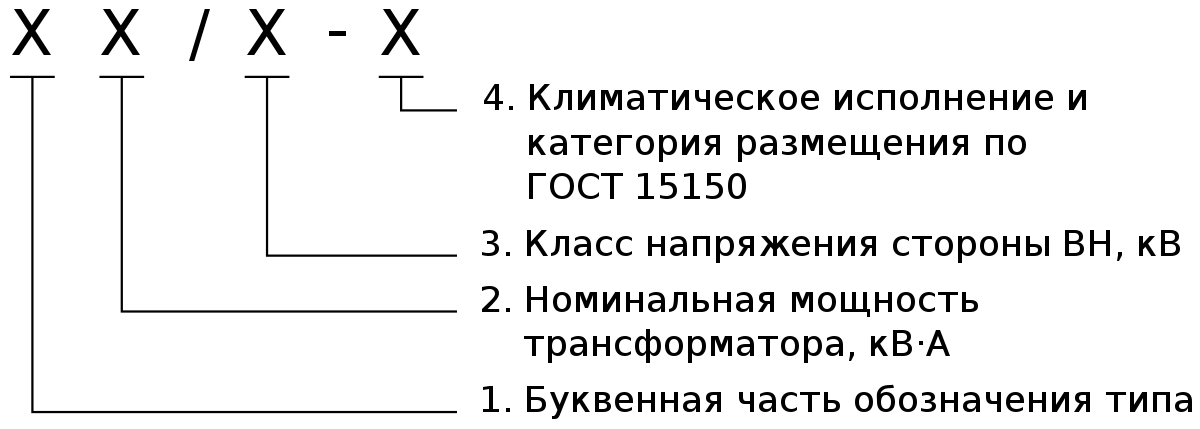

Схема буквенного обозначения типов трансформаторов:

Расшифровка буквенного обозначения силового трансформатора:

1 А – автотрансформатор (может отсутствовать)

2 Число фаз:

Т – трёхфазный

О – однофазный

3 Р – с расщеплённой обмоткой (может отсутствовать)

4 Условное обозначения вида охлаждения:

Масляные трансформаторы

М – естественная циркуляция воздуха и масла

Д — принудительная циркуляция воздуха и естественная циркуляция масла

МВ – с принудительной циркуляцией воды и естественной циркуляцией масла

МЦ — естественная циркуляция воздуха и принудительная циркуляция масла с ненаправленным потоком масла

НМЦ — Естественная циркуляция воздуха и принудительная циркуляция масла с направленным потоком масла

ДЦ – Принудительная циркуляция воздуха и масла с ненаправленным потоком масла

НДЦ — Принудительная циркуляция воздуха и масла с направленным потоком масла

Ц — Принудительная циркуляция воды и масла с ненаправленным потоком масла (в охладителях вода движется по трубам, а масло – в межтрубном пространстве, разделённом перегородками)

НЦ — Принудительная циркуляция воды и масла с направленным потоком масла

Трансформаторы с негорючим жидким диэлектриком

Н — Естественное охлаждение негорючим жидким диэлектриком

НД — Охлаждение негорючим жидким диэлектриком с принудительной циркуляцией воздуха

ННД — Охлаждение негорючим жидким диэлектриком с принудительной циркуляцией воздуха и с направленным потоком жидкого диэлектрика

Сухие трансформаторы

С — Естественное воздушное при открытом исполнении

СЗ — Естественное воздушное при защищенном исполнении

СГ — Естественное воздушное при герметичном исполнении

СД — Воздушное с принудительной циркуляцией воздуха

5 Т – трёхобмоточный трансформатор

6 Н – трансформатор с РПН (с регулированием напряжения под нагрузкой)

7 Особенность исполнения (в обозначении может отсутствовать):

В – с принудительной циркуляцией воды

Г – грозозащитное исполнение

Г – трансформатор в гофрированном баке без расширителя — «герметичное исполнение»

З – трансформатор с естественным масляным охлаждением или с охлаждением негорючим жидким диэлектриком с защитой при помощи азотной подушки, без расширителя и выводами,

смонтированными во фланцах на стенках бака

Л — исполнение трансформатора с литой изоляцией

П — подвесного исполнения на опоре ВЛ

У – усовершенствованное (может быть с автоматическим РПН)

У – трансформатор с симметрирующим устройством

Ф – трансформатор с расширителем и выводами, смонтированными во фланцах на стенках бака

э – трансформатор с пониженными потерями холостого хода (энергосберегающий)

8 Назначение (в обозначении может отсутствовать)

Б – для прогрева бетона или грунта в холодное время года (бетоногрейный), с такой же литерой может обозначаться трансформатор для буровых станков

Б – трансформатор для буровых станков

Ж – для электрификации железных дорог

М – для металлургического производства

П – для линий передачи постоянного тока

ПН – исполнение для питания погружных электронасосов

С – для собственных нужд электростанций (в конце буквенного обозначения)

ТО – для термической обработки бетона и грунта, питания ручного инструмента, временного освещения

Ш – шахтные трансформаторы (предназначены для электроснабжения угольных шахт стационарной установки)

Э – для питания электрооборудования экскаваторов (экскаваторный)

Примеры серий силовых трансформаторов общего назначения: TМ, ТМГ, ТМЭ, ТМЭГ, ТМБ, ТМПН, ТМВГ, ТМВЭГ, ТМВБГ, ТМЖ, ТМВЭ, ТМВБ, ТМЗ, ТМФ, ТМЭБ, ТМВМЗ, ТМС, ТСЗ, ТСЗС, ТРДНС, ТМН,

ТДНС, ТДН, ТМН, ТРДН, ТРДЦН

Примеры:

ТМ – Т – трансформатор трехфазный, М – с естественной циркуляцией воздуха и масла

ТМВГ – Т — трансформатор трехфазный, МВ — с естественной циркуляцией масла и принудительной циркуляцией воды, Г — в герметичном исполнении

ТНЗ – Т — трехфазный, Н — с регулированием под нагрузкой (РПН), З — с естественным масляным

ТМВМ – Т- трехфазный, МВ — с естественной циркуляцией масла и принудительной циркуляцией воды, М – для металлургического производства

ТМГ – Т — трехфазный, М — масляный, Г — в герметичном исполнении

ТМВГ – Т — трехфазный, МВ — с естественной циркуляцией масла и принудительной циркуляцией воды, Г — в герметичном исполнении

ТСЗ – Т — трехфазный, С — естественное воздушное охлаждение, З — в защищенном исполнении;

ТСЗС – Т — трехфазный, С — сухой, З — защищенное исполнение, С — для собственных нужд электростанций

Трехобмоточные: ТМТН, ТДТН, ТДЦТН

Т – стоящая после обозначения системы охлаждения обозначает – трехобмоточный.

Автотрансформаторы: АТДТНГ, АТДЦТНГ, АТДЦТН, АОДЦТН

А – автотрансформатор;

О – однофазный,

Г – грозоупорный.

ТМ 1000/10 74 У1 – Т- трехфазный двух обмоточный трансформатор, М – охлаждение естественная циркуляция воздуха и масла, номинальная мощность — 1000 кВА, класс высшего напряжения — 10 кВ, конструкция — 1974 г., У1 — для района с умеренным климатом, для установки на открытом воздухе;

ТРДНС 25000/35 74 Т1 трехфазный двух обмоточный трансформатор, с расщепленной обмоткой НН, с принудительной циркуляцией воздуха в системе охлаждения, с РПН, для собственных нужд электростанций, номинальная мощность 25 МВА, класс высшего напряжения 35 кВ, конструкция 1974 г., тропического исполнения, для установки на открытом воздухе;

ТЦ 1000000/500 83ХЛ1 трехфазный двух обмоточный трансформатор с принудительной циркуляцией масла и воды в системе охлаждения, номинальная мощность 1000 МВА, класс напряжения 500 кВ, конструкция 1983 г., для районов с холодным климатом, для наружной установки.

Для автотрансформаторов при классах напряжения стороны СН (среднее напряжение) или НН (низкое напряжение) 110 кВ и выше после класса напряжения стороны ВН (высокое напряжение) через черту дроби указывают класс напряжения стороны СН или НН.

Примечание. Для трансформаторов, разработанных до 01.07.87, допускается указывать последние две цифры — год выпуска рабочих чертежей.

Автотрансформаторы отличаются добавлением к обозначению трансформаторов буквы А, она может быть первой в буквенном обозначении или последней.

В автотрансформаторах, изготовленных по основному стандарту трансформаторов ГОСТ 1167765, ГОСТ 1167775, ГОСТ 1167785, буква А стоит впереди всех символов

Например: АОДЦТН 417000/750/500 73У1 однофазный трехобмоточный автотрансформатор номинальной (проходной) мощностью 417 МВА, класс напряжения ВН 750 кВ, СН 500 кВ, остальные символы расшифровываются так же, как и в предыдущих примерах.

В конце 50х годов, когда в СССР впервые появились мощные силовые автотрансформаторы 220/110, 400/220, 400/110, 500/220, 500110 кВ, и в начале 60х годов производили автотрансформаторы двух модификаций повышающей и понижающей. В обозначении повышающей модификации буква А стояла в конце буквенной части; в этих автотрансформаторах обмотку НН выполняли на повышенную мощность и располагали между обмотками СН и ВН, по точной терминологии между общей и последовательной обмотками.

Автотрансформаторы второй модификации понижающей, с буквой А впереди всех символов (как и в новых автотрансформаторах) служат для понижения напряжения, например, с 220 до 110 кВ, или для связи сетей ВН и СН. Обмотка НН в них, как и в новых автотрансформаторах, расположена у стержня, имеет пониженную мощность и несет вспомогательные функции.

Пример обозначения повышающей модификации:

ТДШТА 120000/220, понижающей АТДШТ 120000/220. (Буква Г обозначала грозоупорный, но отменена по мере внедрения ГОСТ 1167765, так как все трансформаторы и автотрансформаторы 110 кВ и выше имеют гарантированную стойкость при грозовых перенапряжениях). В эксплуатации до сих пор встречаются автотрансформаторы обеих модификаций.

ОСНОВНЫЕ ХАРАКТЕРИСТИКИ ТРАНСФОРМАТОРА (АВТОТРАНСФОРМАТОРА), УКАЗАННЫЕ НА ЗАВОДСКОМ ЩИТКЕ (ТАБЛИЧКЕ)

Щиток крепится к баку трансформатора, и указаны следующие параметры:

– тип трансформатора

– число фаз

– частота, Гц

– род установки (наружная или внутренняя)

– номинальная мощность, кВА, для трехобмоточных трансформаторов указывают мощность каждой обмотки

– схема и группа соединения обмоток

– напряжения на номинальной ступени и напряжения ответвлений обмоток, кВ

– номинальный ток, А

– напряжение короткого замыкания в процентах (фактически измеренное, для каждого изделия индивидуальное)

– способ охлаждения трансформатора

– полная масса трансформатора, масла и активной части трансформатора.

Трансформатор ТМН расшифровка

Конечно, у нас собстевенное производство, поэтому мы можем производить не стандартные транс р с боковым подключением вводов и выводов высокого и низкого напряжения. Вправо и влево — вверх и вниз, типа НН и ВН и дополнительными опциями! Сборка любых технических параметров первичной и вторичной обмотки

Да, мы сотрудничаем с официальными дилерами, представительство в России, список таких заводов:

Казахстан — Кентауский трансформаторный завод

Белоруссия Минск — Минский электротехнический завод им Козлова

Украина Богдано Хмельницчкий (Запорожский) — Укрэлектроаппарат

Алтайский Барнаул — Барнаульский Алттранс

Тольяттинский

Самарский — Самара ЗАО Электрощит СЭЩ

Санкт Петербург СПБ Невский — Волхов Великий Новгород

Подольский — ЗАО Трансформер

Чеховский Электрощит

Георгиевский ОАО ГТЗ

Компания кубань электрощит

Марки трансформаторов с естественной масляной системой охлаждения обмоток серии ТМ ТМГ ТМЗ ТМФ ТМГФ. Виды баков гофро (гофрированный) и с радиаторами (радиаторный) А так же доступны линейки сухих трансформаторов ТС ТСЗ ТСЛ ТСЛЗ

Производим повышающие и понажающие напряжение заземление тока, большие цеховые, производственные, промышленные и общепромышленные трансформаторы собственных нужд общего назначения внутренней встроенные в помещение ТП и наружной установки закрытого типа. Выбор наминалы мощности 25 40 63 100 160 250 400 630 1000 (1 мВа) 1250 (1 25 мВа) 1600 (1 6 мВа) 2500 4000 6300 кВа и напряжением 6 10 35 110 0.4 кВ кВт. Можем сделать испытание напряжением под заказ, например компоновка новые типовые проекты из аморфной стали или с глухозаземлённой нейтралью каскадные, разделительные, фланцевые с боковыми вводами выводами. Строительство соответствует нормам ПУЭ и ТУ сертификация систем охлаждения. С необходимыми параметрами и тех характеристиками габаритами размерами весом высотой шириной и доп описание из образеца технического задания справочные данные документация условия работы. Прайс каталог с ценами завода производителя. Производство в России! Фото состав (из чего состоит) и чертежи принципиальная однолинейная электрическая схема по запросу. Срок эксплуатации 25 лет

Поставляем в дачный посёлок коттеджные дачи коттеджи, садовые СНТ товарищества, сельские деревенские местности деревни

Трансформаторы. Расшифровка наименований. Примеры — Всё об энергетике

Трансформаторы. Расшифровка наименований. Примеры

Наименование (а точнее, номенклатура) трансформатора, говорит о его конструктивных особенностях и параметрах. При умении читать наименование оборудования можно только по нему узнать количество обмоток и фаз силового трансформатора, тип охлаждения, номинальную мощность и напряжение высшей обмотки.

Общие рекомендации

Номенклатура трансформаторов (расшифровка буквенных и цифровых обозначений наименования) не регламентируется какими-либо нормативными документами, а всецело определяется производителем оборудования. Поэтому, если название Вашего трансформатора не поддаётся расшифровке, то обратитесь к его производителю или посмотрите паспорт изделия. Приведенные ниже расшифровки букв и цифр названия трансформаторов актуальны для отечественных изделий.

Наименование трансформатора состоит из букв и цифр, каждая из которых имеет своё значение. При расшифровке наименования следует учитывать то что некоторые из них могут отсутствовать в нём вообще (например буква «А» в наименовании обычного трансформатора), а другие являются взаимоисключающими (например, буквы «О» и «Т»).

Расшифровка наименований силовых трансформаторов

Для силовых трансформаторов приняты следующие буквенные обозначения [1, c.238]:

| 1. Автотрансформатор | А |

| 2. Число фаз | |

| Однофазный | О |

| Трёхфазный | Т |

| 3. С расщепленной обмоткой | Р |

| 4. Охлаждение | |

| Сухие трансформаторы: | |

| естественное воздушное при открытом исполнении | С |

| естественное воздушное при защищенном исполнении | СЗ |

| естественное воздушное при герметичном исполнении | СГ |

| воздушное с принудительной циркуляцией воздуха | СД |

| Масляные трансформаторы: | |

| естественная циркуляция воздуха и масла | М |

| принудительная циркуляция воздуха и естественная циркуляция масла | Д |

| естественная циркуляция воздуха и принудительная циркуляция масла с ненаправленным потоком масла | МЦ |

| естественная циркуляция воздуха и принудительная циркуляция масла с направленным потоком масла | НМЦ |

| принудительная циркуляция воздуха и масла с ненаправленным потоком масла | ДЦ |

| принудительная циркуляция воздуха и масла с направленным потоком масла | НДЦ |

| принудительная циркуляция воды и масла с ненаправленным потоком масла | Ц |

| принудительная циркуляция воды и масла с направленным потоком масла | НЦ |

| 5. Трёхобмоточный | Т |

| 6. Переключение ответвлений | |

| регулирование под нагрузкой (РПН) | Н |

| автоматическое регулирование под нагрузкой (АРПН) | АН |

| 7. С литой изоляцией | Л |

| 8. Исполнение расширителя | |

| с расширителем | Ф |

| без расширителя, с защитой при помощи азотной подушки | З |

| без расширителя в гофробаке (герметичная упаковка) | Г |

| 9. С симметрирующим устройством | У |

| 10. Подвесного исполнения (на опоре ВЛ) | П |

| 11. Назначение | |

| для собственных нужд электростанций | С |

| для линий постоянного тока | П |

| для металлургического производства | М |

| для питания погружных электронасосов | ПН |

| для прогрева бетона или грунта (бетоногрейный), для буровых станков | Б |

| для питания электрооборудования экскаваторов | Э |

| для термической обработки бетона и грунта, питания ручного инструмента, временного освещения | ТО |

| шахтные трансформаторы | Ш |

| Номинальная мощность, кВА | [число] |

| Класс напряжения обмотки ВН, кВ | [число] |

| Класс напряжения обмотки СН (для авто- и трёхобмоточных тр-ов), кВ | [число] |

Примечание: принудительная циркуляция вохдуха называется дутьем, то есть «с принудительной циркуляцией воздуха» и «с дутьем» равнозначные выражения.

Примеры расшифровки наименований силовых трансформаторов

ТМ — 100/35 — трансформатор трёхфазный масляный с естественной циркуляцией воздуха и масла, номинальной мощностью 0,1 МВА, классом напряжения 35 кВ;

ТДНС — 10000/35 — трансформатор трёхфазный с дутьем масла, регулируемый под нагрузкой для собственных нужд электростанции, номинальной мощностью 10 МВА, классом напряжения 35 кВ;

ТРДНФ — 25000/110 — трансформатор трёхфазный, с расщеплённой обмоткой, масляный с принудительной циркуляцией воздуха, регулируемый под нагрузкой, с расширителем, номинальной мощностью 25 МВА, классом напряжения 110 кВ;

АТДЦТН — 63000/220/110 — автотрансформатор трёхфазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 63 МВА, класс ВН — 220 кВ, класс СН — 110 кВ;

АОДЦТН — 333000/750/330 — автотрансформатор однофазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 333 МВА, класс ВН — 750 кВ, класс СН — 500 кВ.

Расшифровка наименований регулировочных (вольтодобавочных) трансформаторов

Для регулировочных трансформаторов приняты следующие сокращения [1, c.238][2, c.150]:

| 1. Вольтодобавочный трансформатор | В |

| 2. Регулировочный трансформатор | Р |

| 3. Линейный регулировочный | Л |

| 4. Трёхфазный | Т |

| 5. Тип охлаждения: | |

| принудительная циркуляция воздуха и естественная циркуляция масла | Д |

| естественная циркуляция воздуха и масла | М |

| 6. Регулирование под нагрузкой (РПН) | Н |

| 7. Поперечное регулирование | П |

| 8. Грозоупорное исполнение | Г |

| 9. С усиленным вводом | У |

| Проходная мощность, кВА | [число] |

| Класс напряжения обомотки возбуждения, кВ | [число] |

| Класс напряжения регулировочной обомотки, кВ | [число] |

Примеры расшифровки наименований регулировочных трансформаторов

ВРТДНУ — 180000/35/35 — трансформатор вольтодобавочный, регулировочный, трёхфазный, с масляным охлаждением типа Д, регулируемый под нагрузкой, с усиленным вводом, проходной мощностью 180 МВА, номинальное напряжение обмотки возбуждения 35 кВ, номинальное напряжения регулировочной обмотки 35 кВ;

ЛТМН — 160000/10 — трансформатор линейный, трёхфазный, с естественной циркуляцией масла и воздуха, регулируемый под нагрузкой, проходной мощностью 160 МВА, номинальным линейным напряжением 10 кВ.

Расшифровка наименований трансформаторов напряжения

Для трансформаторов напряжения приняты следующие сокращения [2, c.200]:

| 1. Конец обмотки ВН заземляется | З |

| 2. Трансформатор напряжения | Н |

| 3. Число фаз: | |

| Однофазный | О |

| Трёхфазный | Т |

| 4. Тип изоляции: | |

| Сухая | С |

| Масляная | М |

| Литая эпоксидная | Л |

| 5. Каскадный (для серии НКФ)(1,2) | К |

| 6. В фарфоровой покрышке | Ф |

| 7. С обмоткой для контроля изоляции сети | И |

| 8. С ёмкостным делителем (серия НДЕ) | ДЕ |

| Номинальное напряжение(3), кВ | [число] |

| Климатическое исполнение | [число] |

- Примечание:

- Комплектующий для серии НОСК;

- С компенсационной обмоткой для серии НТМК;

- Кроме серии НОЛ и ЗНОЛ, в которых:

- 06 — для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки;

- 08 — для ЗРУ и КРУ внутренней и наружной установки;

- 11 — для взрывоопасных КРУ.

Примеры расшифровки наименований трансформаторов напряжения

НОСК-3-У5 — трансформатор напряжения однофазный с сухой изоляцией, комплектующий, номинальное напряжение обмотки ВН 3 кВ, климатическое исполнение — У5;

НОМ-15-77У1 — трансформатор напряжения однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1977 года разработки, климатическое исполнение — У1;

ЗНОМ-15-63У2 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1963 года разработки, климатическое исполнение — У2;

ЗНОЛ-06-6У3 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с литой эпоксидной изоляцией, для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки, климатическое исполнение — У3;

НТС-05-УХЛ4 — трансформатор напряжения трёхфазный с сухой изоляцией, номинальное напряжение обмотки ВН 0,5 кВ, климатическое исполнение — УХЛ4;

НТМК-10-71У3 — трансформатор напряжения трёхфазный с масляной изоляцией и компенсационной обмоткой, номинальное напряжение обмотки ВН 10 кВ, 1971 года разработки, климатическое исполнение — У3;

НТМИ-10-66У3 — трансформатор напряжения трёхфазный с масляной изоляцией и обмоткой для контроля изоляции сети, номинальное напряжение обмотки ВН 10 кВ, 1966 года разработки, климатическое исполнение — У3;

НКФ-110-58У1 — трансформатор напряжения каскадный в фарфоровой покрышке, номинальное напряжение обмотки ВН 110 кВ, 1958 года разработки, климатическое исполнение — У1;

НДЕ-500-72У1 — трансформатор напряжения с ёмкостным делителем, номинальное напряжение обмотки ВН 500 кВ, 1972 года разработки, климатическое исполнение — У1;

Расшифровка наименований трансформаторов тока

Для трансформаторов тока приняты следующие сокращения [2, c.201,206-207,213]:

| 1. Трансформатор тока | Т |

| 2. В фарфоровой покрышке | Ф |

| 3. Тип: | |

| Встроенный(1) | В |

| Генераторный | Г |

| Нулевой последовательности | Н |

| Одновитковый | О |

| Проходной(2) | П |

| Усиленный | У |

| Шинный | Ш |

| 4. Исполнение обмотки: | |

| Звеньевого типа | З |

| U-образного типа | У |

| Рымочного типа | Р |

| 5. Исполнение изоляции: | |

| Литая | Л |

| Масляная | М |

| 6. Воздушное охлаждение(3,4) | В |

| 7. Защита от замыкания на землю отдельных жил кабеля(5) | З |

| 8. Категория исполнения | А,Б |

| Номинальное напряжение(6,7) | [число] |

| Ток термической стойкости(8) | [число] |

| Климатическое исполнение | [число] |

- Примечание:

- Для серии ТВ, ТВТ, ТВС, ТВУ;

- Для серии ТНП, ТНПШ — с подмагничиванием переменным током;

- Для серии ТШВ, ТВГ;

- Для ТВВГ — 24 — водяное охлаждение;

- Для серии ТНП, ТНПШ;

- Для серии ТВ, ТВТ, ТВС, ТВУ — номинальное напряжения оборудования;

- Для серии ТНП, ТНПШ — число обхватываемых жил кабеля;

- Для серии ТНП, ТНПШ — номинальное напряжение.

Примеры расшифровки наименований трансформаторов тока

ТФЗМ — 35А — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой звеньевого исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 35 кВ, категории А, климатическим исполнением У1;

ТФРМ — 750М — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой рымочного исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 750 кВ, климатическим исполнением У1;

ТШЛ — 10К — трансформатор тока шинный с литой изоляцией, номинальное напряжением обмотки ВН 10 кВ;

ТЛП — 10К — У3 — трансформатор тока с литой изоляцией, проходной, номинальным напряжением обмотки ВН 10 кВ, климатическое исполнение — У3;

ТПОЛ — 10 — трансформатор тока проходной, одновитковый, с литой изоляцией, номинальным напряжением обмотки ВН 10 кВ;

ТШВ — 15 — трансформатор тока шинный, с воздушным охлаждением, номинальным напряжением обмотки ВН 15 кВ;

ТВГ — 20 — I — трансформатор тока с воздушным охлаждением, генераторный, номинальным напряжением обмотки ВН 20 кВ;

ТШЛО — 20 — трансформатор тока шинный, с литой изоляцией, одновитковый, номинальным напряжением обмотки ВН 20 кВ;

ТВ — 35 — 40У2 — трансформатор тока встроенный, номинальным напряжением обмотки ВН 35 кВ, током термической стойкости 40 кА, климатическое исполнение — У2;

ТНП — 12 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, охватывающий 12 жил кабеля;

ТНПШ — 2 — 15 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, шинный, охватывающий 2 жилы кабеля, номинальным напряжением обмотки ВН 15 кВ.

Список использованных источников

- Справочник по проектированию электрических сетей / под ред. Д.Л. Файбисовича. — 3-е изд., перераб. и доп. — Москва: ЭНАС, 2009. — 392 с.: ил.

- Справочник по электрическим установкам высокого напряжения / под ред. И.А. Баумштейна, С.А. Баженова. — 3-е изд., перераб. и доп. — Москва: Энергоатомиздат, 1989. — 768 с.: ил.

Трансформатор ТМГ: расшифровка, конструкция, технические характеристики

Электроснабжение крупных предприятий и бытовых потребителей производится за счет трансформаторных и районных подстанций. Преобразование электрической энергии в сетях переменного тока осуществляется за счет силовых трансформаторов. Одним из них является трансформатор ТМГ, достаточно часто используемый в отечественных электроустановках.

Расшифровка

Конструкция любой электрической машины имеет свои особенности и назначение, что позволяет использовать их в тех или иных устройствах, климатических зонах или электрических схемах. Для определения особенностей любой модификации трансформатора, следует ознакомиться с его маркировкой и заводским обозначением. Поэтому далее рассмотрим расшифровку на конкретном примере:

ТМГ-250-10-0,4-Υ/ΥН — 0 — У1

- Т – трехфазный трансформатор;

- М – маслонаполненный;

- Г – герметичное исполнение;

- 250 – номинальная мощность агрегата в кВА, как правило, варьируется в пределах от 16 до 2500кВА;

- 10 – номинальное значение обмотки высокого напряжения, для ТМГ это 10 или 6кВ;

- 0,4 – номинальная величина стороны низкого напряжения, измеряемая в киловольтах;

- Υ/ΥН -0 – схема соединения обмоток, по высокой стороне звездой, по низкой звездой с нулевым выводом, группа подключения нулевая. На практике может применяться и другой тип соединения с отличной от нуля группой.

- У1 – тип климатического исполнения.

Конструкция

Технические параметры предусматривают возможность установки силового масляного агрегата в трехфазную сеть. В виду этого устройство имеет ряд конструктивных особенностей, которые обеспечивают как удобство транспортировки, так и последующей эксплуатации на тяговых и трансформаторных подстанциях.

Конструкция трансформатора ТМГ состоит из следующих компонентов:

- Бак – представляет собой герметичную емкость из стали, на поверхности которой могут монтироваться радиаторные отводы и другое вспомогательное оборудование. Трансформаторы ТМГ, как правило, имеют овальную форму бака для электрических машин до 250кВА и прямоугольную в более мощных моделях.

- Магнитопровод – устройство для передачи магнитного потока. В большинстве случаев у трансформаторов ТМГ он выполнен шихтованными наборными пластинами из холоднокатаной стали. Для снижения потерь пластины набираются в косой стык.

- Обмотки – предназначены для пропуска электрического тока и последующей генерации электродвижущей силы, создающей магнитный поток. Изготавливаются из медных или алюминиевых проводников, сечение и форма провода выбирается в зависимости от величины протекающего тока. Могут иметь переключатель величины напряжения РПН.

- Трансформаторное масло – выступает в роли основной среды для отвода тепловой энергии и изоляции токоведущих частей от корпуса. Уровень масла контролируется посредством маслоуказателя поплавочного типа.

- Высоковольтные ввода – предназначены для прохода токоведущих частей через крышку бака. Его конструкция в ТМГ отличается в зависимости от величины пропускаемого тока, как показано на рисунке:

Технические характеристики

При выборе конкретной модели трансформатора ТМГ необходимо руководствоваться его техническими параметрами.

К основным характеристикам масляных трансформаторов относятся:

- Номинальная мощность – показывает, какой объем электрической энергии способен перерабатывает трансформатор.

- Номинальные напряжения – указывают разность потенциалов, обеспечивающую наиболее эффективный режим работы агрегата. Классы напряжения регламентируются как для низкой, так и для высокой стороны.

- Схема и группа подключения обмоток – определяет как напряжение, которое подается или выдается с соответствующей стороны ТМГ, так и направление векторов действующих электрических величин.

- Ток холостого хода – значение потерь в ненагруженном состоянии;

- Напряжение короткого замыкания – процентная величина от номинальной, при которой в короткозамкнутой вторичке будет протекать номинальный ток.

- Потери мощности на намагничивание – определяется величиной вихревых токов.

- Диапазон рабочих температур – как правило, колеблется в пределах от – 40°С до + 40°С, но некоторые трехфазные масляные ТМГ рассчитаны для холодных зон от – 60°С до +40°С.

- Габаритные размеры и масса, также отдельно учитывается вес трансформаторного масла.

Все значения для трансформатора ТМГ можно увидеть в паспорте или на табличке самого агрегата.

Рис. 4. Пример обозначения характеристик на табличке ТМГУсловия эксплуатации

Для трансформаторов ТМГ важно соблюдать параметры его работы как по отношению к состоянию масляного герметичного агрегата, так и относительно внешних факторов. Поэтому он не должен применяться для преобразования электрической энергии при высоте над уровнем моря более 1000м. Также не рекомендуется использовать трансформатор серии ТМГ в условиях частых отключений питания (от 10 и более за сутки), при наличии вибрации в месте установки, во взрывоопасных и пожароопасных зонах.

Рекомендуется устанавливать как в закрытых распредустройствах, так и на улице. Относительная влажность может составлять до 80%. В ходе эксплуатации обязательно контролируется уровень масла по указателю, как техническая характеристика и ее соответствие реальному температурному режиму. Температура, в которой работает электрическая машина не должна выходить за установленные пределы.

Перемещение трансформатора ТМГ должно производиться исключительно в четко зафиксированном положении на подставках, при необходимости производится увязка. Погрузка и выгрузка осуществляется только за специальные петли.

Техническое обслуживание

Под техническим обслуживанием электротехнического оборудования подразумевается комплекс мер, направленных на осуществление постоянного контроля за состоянием ТМГ, поддержание его работоспособности и своевременного выявления дефектов на ранних стадиях. Для этого производятся ежедневные осмотры, производимые оперативным персоналом, текущий ремонт, межремонтные испытания и капитальный ремонт. Объем задач для каждого вида обслуживания определяется как Правилами технической эксплуатации электроустановок потребителей (ПТЭЭП), так и местными инструкциями.

Периодически осуществляется проверка состояния изоляции при помощи мегаомметра. Согласно приложения 3.1. ПТЭЭП измерения выполняются напряжением в 2500 В, а сопротивление электрической изоляции не должно быть менее 500 МОм. Также проверяется тангенс угла диэлектрических потерь, коэффициент трансформации и омическое сопротивление.

При осмотре обращается внимание на состояние радиаторов охлаждения, корпус бака проверяется на наличие подтеков масла. В отличии от сухого трансформатора, по результатам испытаний отбирается масло для анализа. Проверяется работоспособность встроенных защит, включая встроенные специальные трансформаторы для измерений.

Отличия ТМ от ТМГ

Рис. 5. Сравнение трансформаторов ТМГ и ТМТрансформаторы ТМГ нередко сравнивают со схожим по маркировке ТМ, давайте рассмотрим сравнительную характеристику с одним из таких агрегатов на примере следующей таблицы:

Таблица: сравнительные характеристики трансформаторов ТМГ и ТМ

| ТМГ | ТМ |

| Отличается более эффективной конструкцией бака, что позволяет улучшить охлаждение, применяя менее сложную конструкцию | Применяется классический толстостенный бак с радиаторами устаревшего типа. |

| За счет герметизации трансформатора масло не контактирует с атмосферным воздухом, что позволяет сохранять диэлектрические свойства. | На жидкий диэлектрик оказывают воздействие не только внутренние процессы, но и влага из окружающего воздуха. |

| Широко используется конструкция без расширителя. | На крышке устанавливается расширительный бак для обеспечения наполнения емкости. |

| Сигнализатор уровня масла поплавкового типа | Сигнализатор уровня масла трубчатый |

| Проблемы с избыточным давлением из-за отсутствия расширительного бака, газы сбрасываются через клапан. | Избыток газа или масла при нагреве легко перемещается в расширитель или через дыхательный патрон в окружающее пространство. |

| Необходимо постоянно контролировать давление на манометре. | Давление самостоятельно стабилизируется за счет расширителя. |

| Низкие показатели надежности от механических или вибрационных воздействий на трансформатор. | Высокая степень надежности, трансформатор не боится механических воздействий. |

| Непригоден к проведению капитального ремонта со вскрытием крышки, так как затруднена повторная герметизация с закачкой масла. | Капитальный ремонт может производиться любое количество раз. |

| Срок службы от 20 до 30 лет | Срок службы от 40 до 50лет |

Назначение

Трансформатор ТМГ предназначен для питания потребителей различных сфер народного хозяйства, промышленности или бытового сектора. В виду большого разнообразия номинала мощностей ТМГ, их применяют и для электроснабжения отдельных коттеджей, и для работы крупных цехов, подстанций и т.д. Чаще всего применяются как понижающие трансформаторы от сети к потребителю.

Использованная литература

- Э.Л. Мальц, Ю.Н. Мустафаев «Электротехника и электрические машины» 2013

- Почаевец В.С. «Электрические подстанции» 2001

- Марквардт К.Г. «Электроснабжение электрифицированных железных дорог» 1982

- Прохорский А.А. «Тяговые и трансформаторные подстанции» 1983

The Illustrated Transformer — Джей Аламмар — Визуализация машинного обучения по одной концепции за раз.

Обсуждения:

Hacker News (65 баллов, 4 комментария), Reddit r / MachineLearning (29 баллов, 3 комментария)

Переводы: Испанский, Китайский (упрощенный), Корейский, Русский, Вьетнамский, Французский, Японский

Смотреть: лекция MIT по теме «Глубокое обучение» со ссылкой на эту публикацию

В предыдущем посте мы рассмотрели «Внимание» — повсеместный метод в современных моделях глубокого обучения.Внимание — это концепция, которая помогла повысить производительность приложений нейронного машинного перевода. В этом посте мы рассмотрим The Transformer — модель, которая привлекает внимание для повышения скорости обучения этих моделей. Трансформеры превосходят модель нейронного машинного перевода Google в определенных задачах. Однако самое большое преимущество заключается в том, что The Transformer поддается распараллеливанию. Фактически, Google Cloud рекомендует использовать The Transformer в качестве эталонной модели для использования своего предложения Cloud TPU.Итак, давайте попробуем разбить модель на части и посмотрим, как она работает.

Трансформатор был предложен в статье «Внимание — это все, что вам нужно». Его реализация в TensorFlow доступна как часть пакета Tensor2Tensor. Группа НЛП из Гарварда создала руководство с аннотациями к статье с использованием PyTorch. В этом посте мы попытаемся немного упростить вещи и представить концепции одну за другой, чтобы, надеюсь, облегчить понимание людям без глубоких знаний предмета.

2020 Обновление : Я создал видео «Рассказанный трансформер», в котором более мягкий подход к теме:

Взгляд высокого уровня

Давайте начнем с рассмотрения модели как единого черного ящика. В приложении машинного перевода оно берет предложение на одном языке и выводит его перевод на другом.

Раскрывая эту доброту Оптимуса Прайма, мы видим компонент кодирования, компонент декодирования и связи между ними.

Компонент кодирования представляет собой стек кодировщиков (на бумаге шесть из них складываются друг на друга — в числе шесть нет ничего волшебного, можно определенно поэкспериментировать с другими компоновками). Компонент декодирования представляет собой стек декодеров с одинаковым числом.

Все кодировщики идентичны по структуре (но у них нет общих весов). Каждый из них разбит на два подслоя:

Входные данные кодировщика сначала проходят через слой самовнимания — слой, который помогает кодировщику смотреть на другие слова во входном предложении, когда он кодирует определенное слово.Позже мы подробнее рассмотрим самовнимание.

Выходные данные слоя самовнимания передаются в нейронную сеть с прямой связью. Точно такая же сеть прямой связи независимо применяется к каждой позиции.

В декодере есть оба этих уровня, но между ними есть уровень внимания, который помогает декодеру сосредоточиться на соответствующих частях входного предложения (аналогично тому, что делает внимание в моделях seq2seq).

Использование тензоров в картине

Теперь, когда мы увидели основные компоненты модели, давайте начнем смотреть на различные векторы / тензоры и то, как они перемещаются между этими компонентами, чтобы превратить входные данные обученной модели в выходные данные.

Как и в случае с приложениями НЛП в целом, мы начинаем с преобразования каждого входного слова в вектор с помощью алгоритма встраивания.

Каждое слово вложено в вектор размером 512. Мы представим эти векторы этими простыми прямоугольниками.

Встраивание происходит только в самый нижний кодировщик. Абстракция, которая является общей для всех кодировщиков, заключается в том, что они получают список векторов, каждый размером 512. В нижнем кодировщике это будет слово embeddings, но в других кодировщиках это будет выход кодировщика, который находится непосредственно под .Размер этого списка — это гиперпараметр, который мы можем установить — в основном это будет длина самого длинного предложения в нашем наборе обучающих данных.

После встраивания слов в нашу входную последовательность каждое из них проходит через каждый из двух уровней кодировщика.

Здесь мы начинаем видеть одно ключевое свойство преобразователя, а именно то, что слово в каждой позиции проходит свой собственный путь в кодировщике. Между этими путями на уровне самовнимания есть зависимости.Однако слой прямой связи не имеет этих зависимостей, и, таким образом, различные пути могут выполняться параллельно при прохождении через слой прямой связи.

Затем мы заменим пример более коротким предложением и посмотрим, что происходит на каждом подуровне кодировщика.

Теперь мы кодируем!

Как мы уже упоминали, кодировщик получает на вход список векторов. Он обрабатывает этот список, передавая эти векторы в слой «самовнимания», затем в нейронную сеть с прямой связью, а затем отправляет выходные данные вверх следующему кодировщику.

Слово в каждой позиции проходит через процесс самовнимания. Затем каждый из них проходит через нейронную сеть с прямой связью — точно такую же сеть с каждым вектором, протекающим через нее отдельно.

Самовнимание на высоком уровне

Не обманывайтесь, когда я использую слово «самовнимание», как будто это понятие должно быть знакомо каждому. Я лично никогда не сталкивался с этой концепцией до тех пор, пока не прочитал статью «Все, что вам нужно». Давайте разберемся, как это работает.

Скажем, следующее предложение является вводным предложением, которое мы хотим перевести:

” Животное не переходило улицу, потому что оно слишком устало ”

Что означает «оно» в этом предложении? Имеется в виду улица или животное? Это простой вопрос для человека, но не такой простой для алгоритма.

Когда модель обрабатывает слово «оно», самовнимание позволяет ей ассоциировать «это» с «животным».

По мере того, как модель обрабатывает каждое слово (каждую позицию во входной последовательности), самовнимание позволяет ей смотреть на другие позиции во входной последовательности в поисках подсказок, которые могут помочь улучшить кодирование этого слова.

Если вы знакомы с RNN, подумайте о том, как поддержание скрытого состояния позволяет RNN включать свое представление предыдущих слов / векторов, которые она обработала, с текущим, обрабатываемым ею. Самовнимание — это метод, который Трансформер использует для «запекания» других релевантных слов в словах, которые мы обрабатываем в данный момент.

Поскольку мы кодируем слово «оно» в кодировщике №5 (верхний кодировщик в стеке), часть механизма внимания фокусировалась на «Животном» и запекла часть его представления в кодировке «оно».

Обязательно ознакомьтесь с записной книжкой Tensor2Tensor, где вы можете загрузить модель Transformer и изучить ее с помощью этой интерактивной визуализации.

Самостоятельное внимание в деталях

Давайте сначала посмотрим, как вычислить самовнимание с помощью векторов, а затем перейдем к тому, как это на самом деле реализовано — с помощью матриц.

Первый шаг в вычислении самовнимания состоит в том, чтобы создать три вектора из каждого из входных векторов кодировщика (в данном случае — вложение каждого слова).Итак, для каждого слова мы создаем вектор запроса, вектор ключа и вектор значения. Эти векторы создаются путем умножения вложения на три матрицы, которые мы обучили в процессе обучения.

Обратите внимание, что эти новые векторы меньше по размерности, чем вектор внедрения. Их размерность составляет 64, в то время как векторы ввода / вывода встраивания и кодировщика имеют размерность 512. Они НЕ ДОЛЖНЫ быть меньше, это выбор архитектуры, позволяющий сделать вычисление многогранного внимания (в основном) постоянным.

Умножение x1 на весовую матрицу WQ дает q1, вектор «запроса», связанный с этим словом. В итоге мы создаем проекцию «запроса», «ключа» и «значения» для каждого слова во входном предложении.

Что такое векторы «запроса», «ключа» и «значения»?

Это абстракции, которые полезны для вычисления внимания и размышления о нем. После того, как вы перейдете к прочтению того, как рассчитывается внимание ниже, вы будете знать почти все, что вам нужно знать о роли каждого из этих векторов.

Второй шаг в вычислении самовнимания — это подсчет баллов. Предположим, мы рассчитываем самовнимание для первого слова в этом примере «Мышление». Нам нужно сопоставить каждое слово входного предложения с этим словом. Оценка определяет, сколько внимания следует уделять другим частям входного предложения, когда мы кодируем слово в определенной позиции.

Оценка рассчитывается как скалярное произведение вектора запроса на ключевой вектор соответствующего слова, которое мы оцениваем.Итак, если мы обрабатываем самовнимание для слова в позиции №1, первая оценка будет скалярным произведением q1 и k1. Вторая оценка будет скалярным произведением q1 и k2.

Третий и четвертый этапы заключаются в разделении оценок на 8 (квадратный корень из размерности ключевых векторов, используемых в статье — 64. Это приводит к получению более стабильных градиентов. Здесь могут быть другие возможные значения, но это значение по умолчанию), затем передайте результат через операцию softmax.Softmax нормализует оценки, чтобы все они были положительными и в сумме составляли 1.

.Эта оценка softmax определяет, насколько каждое слово будет выражено в этой позиции. Очевидно, что слово в этой позиции будет иметь самый высокий балл softmax, но иногда полезно обратить внимание на другое слово, имеющее отношение к текущему слову.

Пятый шаг — это умножение каждого вектора значений на оценку softmax (при подготовке к их суммированию). Интуиция здесь заключается в том, чтобы сохранить неизменными значения слов, на которых мы хотим сосредоточиться, и заглушить не относящиеся к делу слова (умножив их на крошечные числа, такие как 0.001, например).

Шестой этап заключается в суммировании векторов взвешенных значений. Это производит вывод слоя самовнимания в этой позиции (для первого слова).

На этом расчет самовнимания завершен. Результирующий вектор — это тот, который мы можем отправить в нейронную сеть с прямой связью. Однако в реальной реализации этот расчет выполняется в матричной форме для более быстрой обработки. Итак, давайте посмотрим на это теперь, когда мы увидели интуитивное вычисление на уровне слов.

Матрица расчета самовнимания

Первым шагом является вычисление матриц запроса, ключа и значения. Мы делаем это, упаковывая наши вложения в матрицу X и умножая ее на матрицы весов, которые мы обучили (WQ, WK, WV).

Каждая строка в матрице X соответствует слову во входном предложении. Мы снова видим разницу в размере вектора встраивания (512 или 4 прямоугольника на рисунке) и векторов q / k / v (64 или 3 прямоугольника на рисунке).

Наконец, , поскольку мы имеем дело с матрицами, мы можем объединить шаги со второго по шестой в одну формулу, чтобы вычислить результаты слоя самовнимания.

Расчет самовнимания в матричной форме

Многоголовый зверь

В статье дополнительно усовершенствован слой самовнимания, добавлен механизм, называемый «многоголовым» вниманием. Это улучшает производительность слоя внимания двумя способами:

Расширяет способность модели фокусироваться на разных позициях. Да, в приведенном выше примере z1 содержит немного любой другой кодировки, но в ней может преобладать само слово.Было бы полезно, если бы мы переводили предложение вроде «Животное не перешло улицу, потому что оно слишком устало», мы хотели бы знать, к какому слову «оно» относится.

Он дает слою внимания несколько «подпространств представления». Как мы увидим дальше, с многоголовым вниманием у нас есть не только один, но и несколько наборов весовых матриц запроса / ключа / значения (преобразователь использует восемь головок внимания, поэтому мы получаем восемь наборов для каждого кодировщика / декодера). . Каждый из этих наборов инициализируется случайным образом.Затем, после обучения, каждый набор используется для проецирования входных вложений (или векторов из нижних кодировщиков / декодеров) в другое подпространство представления.

С многоголовым вниманием мы поддерживаем отдельные весовые матрицы Q / K / V для каждой головы, в результате чего получаются разные матрицы Q / K / V. Как и раньше, мы умножаем X на матрицы WQ / WK / WV, чтобы получить матрицы Q / K / V.

Если мы проделаем тот же самый расчет самовнимания, который мы описали выше, всего восемь раз с разными весовыми матрицами, мы получим восемь разных Z-матриц

Это оставляет нам небольшую проблему.Слой прямой связи не ожидает восьми матриц — он ожидает единственную матрицу (вектор для каждого слова). Итак, нам нужен способ сжать эти восемь в единую матрицу.

Как мы это делаем? Мы объединяем матрицы, а затем умножаем их на дополнительную матрицу весов WO.

Вот и все, что нужно для многоглавого самовнимания. Я понимаю, что это довольно много матриц. Позвольте мне попытаться объединить их все в один визуальный ряд, чтобы мы могли рассматривать их в одном месте

Теперь, когда мы коснулись головок внимания, давайте вернемся к нашему предыдущему примеру, чтобы увидеть, где фокусируются различные головы внимания, когда мы кодируем слово «оно» в нашем примере предложения:

Когда мы кодируем слово «оно», одна голова внимания больше всего сосредотачивается на «животном», в то время как другая фокусируется на «усталом» — в некотором смысле, представление модели слова «оно» вписывается в некоторые из представлений. как «животное», так и «уставшее».

Однако, если мы добавим к изображению все внимание, интерпретировать вещи будет сложнее:

Представление порядка последовательности с использованием позиционного кодирования

В модели, которую мы описали до сих пор, отсутствует одна вещь, так это способ учесть порядок слов во входной последовательности.

Чтобы решить эту проблему, преобразователь добавляет вектор к каждому встраиванию входа. Эти векторы следуют определенному шаблону, который модель изучает, что помогает ей определять положение каждого слова или расстояние между разными словами в последовательности.Интуиция здесь заключается в том, что добавление этих значений к вложениям обеспечивает значимые расстояния между векторами встраивания, когда они проецируются в векторы Q / K / V и во время внимания скалярного произведения.

Чтобы дать модели ощущение порядка слов, мы добавляем векторы позиционного кодирования, значения которых следуют определенному шаблону.

Если бы мы предположили, что вложение имеет размерность 4, фактическое позиционное кодирование будет выглядеть так:

Реальный пример позиционного кодирования с размером вложения игрушки 4

Как мог бы выглядеть этот узор?

На следующем рисунке каждая строка соответствует позиционному кодированию вектора.Таким образом, первая строка будет вектором, который мы добавим к встраиванию первого слова во входной последовательности. Каждая строка содержит 512 значений — каждое от 1 до -1. Мы присвоили им цветовую кодировку, чтобы узор был виден.

Реальный пример позиционного кодирования для 20 слов (строк) с размером встраивания 512 (столбцов). Вы можете видеть, что он разделен пополам по центру. Это потому, что значения левой половины генерируются одной функцией (которая использует синус), а правая половина генерируется другой функцией (которая использует косинус).Затем они объединяются, чтобы сформировать каждый из векторов позиционного кодирования.

Формула позиционного кодирования описана в статье (раздел 3.5). Вы можете увидеть код для генерации позиционных кодировок в get_timing_signal_1d () . Это не единственный возможный метод позиционного кодирования. Однако это дает преимущество возможности масштабирования до невидимой длины последовательностей (например, если нашу обученную модель просят перевести предложение длиннее, чем любое из предложений в нашем обучающем наборе).

Июль 2020 Обновление: Позиционное кодирование, показанное выше, взято из реализации преобразователя Tranformer2Transformer. Метод, показанный в статье, немного отличается тем, что он не соединяет напрямую, а переплетает два сигнала. На следующем рисунке показано, как это выглядит. Вот код для его создания:

Остатки

Одна деталь в архитектуре кодера, которую мы должны упомянуть, прежде чем двигаться дальше, заключается в том, что каждый подуровень (самовнимание, ffnn) в каждом кодере имеет остаточное соединение вокруг себя, за которым следует этап нормализации уровня. .

Если мы визуализируем векторы и операцию уровня-нормы, связанную с самовниманием, это будет выглядеть так:

Это также относится к подуровням декодера. Если мы представим себе преобразователь из двух стековых кодировщиков и декодеров, он будет выглядеть примерно так:

Сторона декодера

Теперь, когда мы рассмотрели большинство концепций кодировщика, мы в основном знаем, как работают компоненты декодеров.Но давайте посмотрим, как они работают вместе.

Кодер запускает обработку входной последовательности. Затем выходной сигнал верхнего кодера преобразуется в набор векторов внимания K и V. Они должны использоваться каждым декодером на его уровне «внимание кодер-декодер», который помогает декодеру сосредоточиться на соответствующих местах во входной последовательности:

После завершения этапа кодирования мы начинаем этап декодирования. Каждый шаг на этапе декодирования выводит элемент из выходной последовательности (в данном случае это предложение английского перевода).

Следующие шаги повторяют процесс до тех пор, пока не будет достигнут специальный символ, указывающий, что декодер трансформатора завершил свой вывод. Выходные данные каждого шага поступают в нижний декодер на следующем временном шаге, и декодеры выводят свои результаты декодирования точно так же, как это сделали кодеры. И так же, как мы поступили с входами кодировщика, мы встраиваем и добавляем позиционное кодирование к этим входам декодера, чтобы указать положение каждого слова.

Слои самовнимания в декодере работают немного иначе, чем в кодировщике:

В декодере слой самовнимания может обращать внимание только на более ранние позиции в выходной последовательности.Это делается путем маскировки будущих позиций (установка для них значений -inf ) перед шагом softmax в расчете самовнимания.

Слой «Внимание кодировщика-декодера» работает так же, как многоголовое самовнимание, за исключением того, что он создает свою матрицу запросов из нижележащего уровня и берет матрицу ключей и значений из выходных данных стека кодировщика.

Последний линейный слой и слой Softmax

Стек декодера выводит вектор чисел с плавающей запятой. Как превратить это в слово? Это работа последнего слоя Linear, за которым следует слой Softmax.