Что такое дифавтомат и для чего его применяют?

Дифференциальный автомат — это низковольтный комбинированный электрический аппарат, совмещающий в одном корпусе функции двух защитных устройств — УЗО и автоматического выключателя. Благодаря этому данное изделие является достаточно популярным и широко применяется как в бытовых условиях, так и на производстве. В этой статье мы рассмотрим устройство, назначение и принцип работы дифавтомата.Во-первых, данный электрический аппарат служит для защиты участка электрической сети от повреждения из-за протекания по нему сверхтоков, которые возникают при перегрузке или коротком замыкании (функция автоматического выключателя). Во-вторых, дифференциальный автомат предотвращает возникновение пожара и поражение людей электрическим током в результате возникновения утечки электричества через поврежденную изоляцию кабеля линии электропроводки или неисправного бытового электроприбора (функция устройства защитного отключения).

Устройство и принцип действия

Для начала приведем обозначение на схеме по ГОСТ, по которому наглядно видно, из чего состоит дифавтомат:

На обозначении видно, что основными элементами конструкции дифавтомата является дифференциальный трансформатор (1), электромагнитный (2) и тепловой (3) расцепители. Ниже кратко охарактеризуем каждый из приведенных элементов.

Дифференциальный трансформатор имеет несколько обмоток, в зависимости от количества полюсов устройства. Данный элемент осуществляет сравнение токов нагрузки по проводникам и в случае их несимметричности на выходе вторичной обмотки данного трансформатора появляется так называемый ток утечки. Он поступает на пусковой орган, который без выдержки времени осуществляет расцепление силовых контактов автомата.

Также следует упомянуть о кнопке проверки работоспособности защитного аппарата «TEST». Данная кнопка подключается последовательно с сопротивлением, которое включается или отдельной обмоткой на трансформатор либо параллельно одной из имеющихся. При нажатии на данную кнопку сопротивление создает искусственный небаланс токов – возникает дифференциальный ток и дифавтомат должен сработать, что свидетельствует о его исправном состоянии.

При нажатии на данную кнопку сопротивление создает искусственный небаланс токов – возникает дифференциальный ток и дифавтомат должен сработать, что свидетельствует о его исправном состоянии.

Электромагнитный расцепитель представляет собой электромагнит с сердечником, который воздействует на механизм отключения. Данный электромагнит срабатывает в случае достижения тока нагрузки порога срабатывания — обычно это случается при возникновении короткого замыкания. Данный расцепитель срабатывает мгновенно, за доли секунд.

Тепловой расцепитель осуществляет защиту электрической сети от перегрузки. Конструктивно представляет собой биметаллическую пластину, которая деформируется при протекании через нее тока нагрузки, превышающего номинальный для данного аппарата. При достижении определенного положения биметаллическая пластина воздействует на механизм отключения дифавтомата. Срабатывание теплового расцепителя происходит не сразу, а с выдержкой времени. Время срабатывания прямо пропорционально величине тока нагрузки, протекающего по дифференциального автомату, а также зависит от температуры окружающей среды.

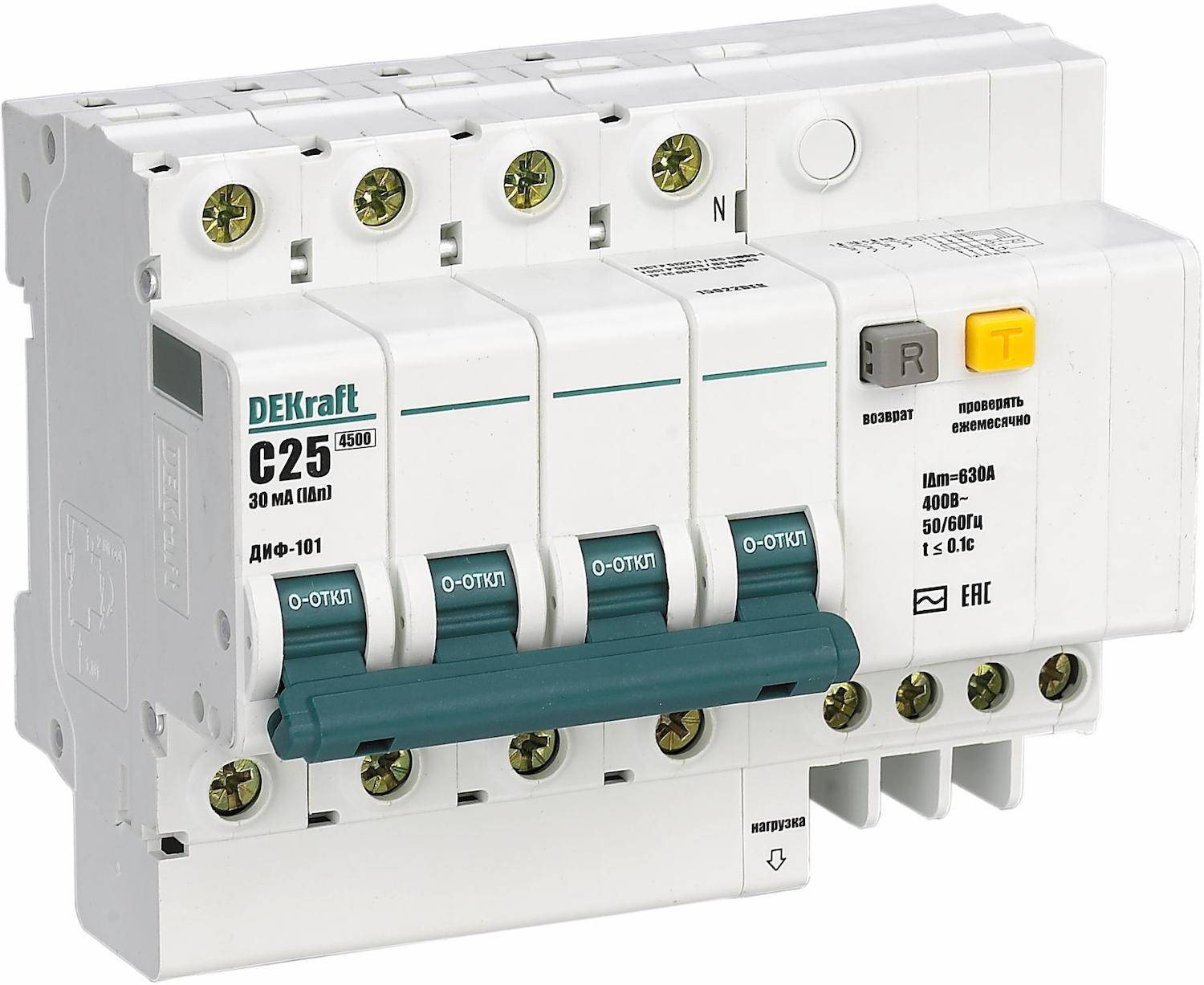

На корпусе указывается порог срабатывания дифференциального трансформатора — ток утечки в мА, номинальный ток теплового расцепителя (при котором работает неограниченное время) в А. Пример маркировки на корпусе — С16 А / 30 мА. В данном случае маркировка “С” перед значением номинала показывает кратность срабатывания электромагнитного расцепителя (класс аппарата). Буква “С” указывает, что электромагнитный расцепитель сработает при превышении номинала 16А в 5-10 раз.

Область применения

Для чего применяют дифференциальный автомат, если существует два отдельных защитных аппарата (УЗО и автомат), каждый из которого выполняет свою функцию?

Основное преимущество дифавтомата — компактность. Он занимает меньше места на DIN-рейке в электрическом распределительном щитке, чем в случае установки двух отдельных аппаратов. Эта особенность особенно актуальная при необходимости установки в распределительном щитке нескольких устройств защитного отключения и автоматических выключателей. В данном случае посредством установки дифавтоматов можно значительно сэкономить место в распределительном щитке и соответственно уменьшить его размер.

В данном случае посредством установки дифавтоматов можно значительно сэкономить место в распределительном щитке и соответственно уменьшить его размер.

Дифференциальный автомат широко применяется для защиты электропроводок практически повсеместно, как в быту, так и в помещениях другого назначения (в различных учреждениях, на предприятиях).

Дифавтомат ничем не уступает аналогичным по характеристикам УЗО и автоматическому выключателю, поэтому каких-либо ограничений в его применении нет. Данный защитный аппарат можно устанавливать, как на вводе (в качестве резервирующего), так и на отходящих линиях электропроводки для обеспечения пожаробезопасности, безопасности людей в отношения поражения электричеством, а также для защиты от сверхтоков.

Источник: сайт Сам электрик.

Автоматический выключатель, дифференциальный автомат и УЗО: в чем отличие?

Сеть, которая постоянно находится под напряжением, рано или поздно может выйти из строя. Причин для этого много, а вот последствия такого сбоя не очень приятные. Во-первых, могут пострадать провода или подключенные к розеткам электрические приборы. Во-вторых, пользователь может получить разряд тока. Чтобы этого избежать используют различные средства защиты, которые прекрасно подходят для бытовых условий и снижают риск появления поломок.

Во-первых, могут пострадать провода или подключенные к розеткам электрические приборы. Во-вторых, пользователь может получить разряд тока. Чтобы этого избежать используют различные средства защиты, которые прекрасно подходят для бытовых условий и снижают риск появления поломок.

К таким устройствам относят УЗО, автоматические выключатели и диффавтоматы. Они быстро отключают цепь питания, и напряжение не успевает перейти в разряд опасного, способного испортить приборы. Учитывая, что устройства выполняют похожую функцию, многим кажется не важным, какое из них будет установлено в помещении. На самом деле они отличаются и по назначению, и по конструкции. Поэтому перед покупкой рекомендуется изучить все важные нюансы, чтобы подобрать оптимальный аппарат.

От чего защищают.

Неисправности в электрической цепи чаще всего вызваны тремя основными факторами:

1. Короткое замыкание. Сопротивление электронагрузки снижается до минимума, из-за воздействия металлических предметов на цепь напряжения.

2. Токи утечек. Возникают, когда нарушена изоляция. При случайном возникновении цепей на земле.

3. Перегруз проводов. Если в помещении работают приборы большой мощности, это вызывает в цепи повышенное напряжение и, соответственно, перегрев проводов и самих приборов. В итоге страдает изоляция, повышается риск ее воспламенения.

Все эти факторы могут возникать по отдельности, а иногда и вместе. Например, перегрев проводов может вызвать короткое замыкание.

Отличие по назначению.

Автоматические выключатели.

Они предохраняют от короткого замыкания и токов утечек. Существует несколько разновидностей, отличаются они номинальным током и габаритами. Но у каждой модели в комплекцию включены:

Электромагнитная катушка – она отключает токи напряжения и способствует гашению электрической дуги.

Тепловой расцепитель (с выдержкой времени) – в основе биметаллическая пластина, которая начинает работать при возникновении перегруза внутри цепи.

Нужно учитывать, что для жилых зданий автоматический выключатель подключается только на одну фазу. А значит, он контролирует только напряжение этой фазы. Любые токи утечек прибор будет игнорировать.

УЗО (устройство защитного отключения).

Для подключения используется два провода: ноль и фаза. Устройство считывает токи, проходящие через них, и вычисляет разницу между ними. Если номинал, выходящий через ноль равен входящему в фазу – все нормально, УЗО не останавливает работу сети. Небольшие величины также игнорируются, поскольку не влияют на безопасность.

Но как только ток утечки превысит отметку оптимального, устройство снимает напряжение внутри работающей схемы. Прибор автоматически настроен на срабатывание, когда достигнута определенная разница токов уставки. Это позволяет избежать ненужных отключений и предотвращать только реально опасные ситуации.

Но нюанс в том, что само защитное устройство не застраховано от перегрузов и коротких замыканий.![]() Поэтому его устанавливают в комплексе с автоматическим выключателем.

Поэтому его устанавливают в комплексе с автоматическим выключателем.

Дифференциальный автомат.

Наиболее надежная защита. По сути, он включает в себя оба описанных выше устройства и спасает от всех трех видов неисправностей. Плюс, в его конструкции тепловой и электромагнитный расцепители, которые защищают автомат от перегрева и коротких замыканий. Да, эта конструкция стоит дороже, но и защита более надежная. Кроме того, выполнен он одним модулем.

Внешние отличия.

Габариты.

Для начала стоит сказать, что каждый из аппаратов выполнен с возможностью монтажа на din-рейку. Это позволяет сэкономить место и легко пристроить прибор внутри этажного или квартирного щитка. Однако даже такая технология не спасает от нехватки места при укомплектовании электрических проводов. Автоматический выключатель и УЗО создаются с разными корпусами, поэтому их нужно монтировать отдельно. А вот диффавтомат закрепляется одним модулем, что существенно экономит и место, и время.

Также стоит учитывать, что при монтаже всегда нужно оставлять дополнительное пространство. Чтобы была возможность установить приборы при доработке схемы.

Маркировка.

Все три прибора имеют кнопку «Тест», рычаг ручного включения и похожий корпус. На каждом прикреплена табличка, на которой указаны основные данные: номинальный ток, напряжение в электропроводке, при котором устройство работает, контролируемые токи утечки, схема подключения внутренних деталей. Единственное отличие – на УЗО не отображены токовые защиты, поскольку они не предусмотрены. На лицевой стороне пропечатана модель аппарата, чтобы покупатель сразу мог понять, приобретает он автоматический выключатель или дифференциальный.

Важно: многие путают обозначения ВД и АВДТ. Первое – выключатель дифференциальный. По сути, это УЗО, которое защищает только от токов утечки. Второй – автоматический выключатель дифференциального тока. Здесь уже говорим о классическом диффавтомате, который предотвращает и КЗ, и утечки, и перегрев.

Дополнительные сведения.

Монтаж.

Легко монтируется как один модуль, так и два. Отличие только в том, что установка двух аппаратов займет больше времени. Основные трудности возникают при подключении проводов. УЗО и «дифференциалки» подключаются только к нулю и фазе. А вот автоматический выключатель требует дополнительного объема работы: придется прокладывать перемычки.

Долговечность.

Считается, что чем сложнее конструкция, тем быстрее она сломается. УЗО и выключатели довольно простые по конструкции, поэтому в случае неполадок детали можно легко найти и заменить. Сам ремонт аппарата не сильно ударит по кошельку, а в большинстве случаев неисправности можно починить и самостоятельно, без глубоких познаний в электрике.

Дифференциальный автомат в этом плане проигрывает. Конечно, судить о надежности по сложности конструкции нельзя. Все зависит от качества сборки деталей, добросовестности производителя и так далее. Но в случае поломки придется обратиться к профессионалу и потратиться.

Но в случае поломки придется обратиться к профессионалу и потратиться.

Вывод.

Итак, какое из устройств выбрать зависит от бюджета и особенностей помещения. Тем не менее, надежную защиту обеспечат все три аппарата, которые обязательно нужно включать в схему электрической проводки.

Как отличить Дифференциальный автомат от УЗО?

Сперва рассмотрим принцип работы УЗО. Внутри УЗО находится специальный трансформатор, в котором каждый из проводников (L-фаза, N-нуль) создает электромагнитное поле. При нормальной работе они друг друга аннулируют. При возникновении утечки тока, в катушке происходит дисбаланс электромагнитного поля, в итоге, стержень толкает рычаг на выключение. Такое устройство срабатывает на выключение от утечки тока, но не предназначено для защиты от коротких замыканий и перегрузок сети.

Как работает дифференциальный автоматический выключатель (диф. автомат)?

Теперь поговорим о диф.автомате (дифференциальной защите тока и общей защите). Прибор предназначен для защиты цепи от утечки тока (аналогично работе Узо), но преимущество диф. автомата заключается в том, что в него встроен автоматический выключатель, который выполняет функцию защиты цепи от коротких замыканий и перегрузок. Два в одном: УЗО+ Автоматический выключатель= Дифференциальный автомат. Получился своего рода технический симбиоз.

Прибор предназначен для защиты цепи от утечки тока (аналогично работе Узо), но преимущество диф. автомата заключается в том, что в него встроен автоматический выключатель, который выполняет функцию защиты цепи от коротких замыканий и перегрузок. Два в одном: УЗО+ Автоматический выключатель= Дифференциальный автомат. Получился своего рода технический симбиоз.

Если под обычным Узо устанавливают 3 или 4 группы отдельных автоматических выключателей, то диф.автомат обеспечивает отдельную группу для защиты электрической цепи. Под диф.автоматом не устанавливают автоматические выключатели, он несет самостоятельную ответственность за короткое замыкание (КЗ), перегрузку электрической цепи и утечку тока в землю. Можно конечно и поставить автоматические выключатели под диф. автоматом, но это расточительно.

Читайте следующие статьи про УЗО:

Где устанавливают дифференциальные автоматические выключатели?

Устанавливают диф. автомат там, где требуется постоянное питание приборов, например, таких приборов как: охранная сигнализация, пожарная сигнализация, морозильник, компьютер и т.д. Группа работает автономно, т.е. на ветке больше никто не сидит. Обычное Узо отсекает сразу три, а то и больше групп, а это значит, что если где-то произошла утечка тока, к примеру, в стиральной машине, УЗО отключит не только её, но и все остальные приборы.

автомат там, где требуется постоянное питание приборов, например, таких приборов как: охранная сигнализация, пожарная сигнализация, морозильник, компьютер и т.д. Группа работает автономно, т.е. на ветке больше никто не сидит. Обычное Узо отсекает сразу три, а то и больше групп, а это значит, что если где-то произошла утечка тока, к примеру, в стиральной машине, УЗО отключит не только её, но и все остальные приборы.

Что нужно учесть устанавливая дифференциальный автоматический выключатель?

При установке необходимо учесть габариты диф.автомата. Обычное УЗО — размером в 2 модуля, тогда как диф.автомат — на все 4 модуля в однофазной сети. В зависимости от того, сколько вы хотите проложить отдельных групп, следует подобрать соответствующий распределительный щит для автоматических выключателей дифференциального тока, очень уж много они занимают пространственного места. Но есть диф. автоматы размером в 2 модуля — более компактные, которые позволяют сэкономить в распределительном щите много места.

Обязательно прочитайте следующую статью про установку реле «Почему нужно устанавливать реле контроля напряжения?»

Оцените качество статьи:

Что такое дифавтомат, для чего применяют, схемы, как подключить

Из статьи вы узнаете, что такое дифавтомат и для чего применяют, какие бывают, устройство и принцип действия устройства, принципиальная схема, расшифровка обозначений на корпусе, как подключить.

Безопасность – это важно

При проектировании и прокладке низковольтной электрической сети одной из главных задач для специалистов является защита от коротких замыканий и обеспечение максимального уровня безопасности.

Для ее решения применяются специальные устройства, одним из которых является дифференциальный автомат (дифавтомат).

Ниже рассмотрим следующие вопросы:

- Что это за изделие?

- Для чего применяют, и какие виды дифавтоматов бывают?

- Из каких элементов он состоит, и как работает?

- Как расшифровать обозначения и подключить дифавтомат?

- В чем причины срабатывания?

Определение дифавтомата

Дифференциальный автомат — защитное устройство, которое устанавливается в низковольтной сети для обеспечения ее комплексной защиты.

В одном аппарате объединяется две функции — автоматического выключателя (отсечки) и УЗО.

Благодаря расширенным возможностям, изделие пользуется широким спросом в быту и на производстве.

Сфера применения

Дифавтомат применяется для решения следующих задач:

- Защиты определенного участка сети от протекания повышенных токов, возникающих в случае КЗ или перегрузки.

- Предотвращения пожара или попадания людей под действие напряжения из-за появления утечки, возникающей по причине некачественной изоляции проводов или выхода из строя бытовых приборов.

В первом случае дифференциальный автомат работает как автоматический выключатель, а во втором — как УЗО (устройство защитного отключения).

Какие виды бывают?

Дифференциальный автомат — универсальный аппарат, который может с легкостью применяться в одно-, так и трехфазных сетях.

В первом случае используются изделия с двумя полюсами, а во втором — с четырьмя.

Читайте также:Конструктивные особенности, принцип действия и схема дифавтомата

Рассматривая обозначение устройства по ГОСТ, несложно выделить конструктивные элементы защитного аппарата.

К основным стоит отнести:

- Дифференциальный трансформатор;

- Группа расцепителей (тепловой и электромагнитный).

Каждый из элементов выполняет определенные задачи. Рассмотрим их подробнее.

Дифтрансформатор — устройство с несколькими обмотками, число которых напрямую зависит от количества полюсов.

В его задачу входит сравнение нагрузочных токов в каждом из проводников. В случае расхождения показателей появляется ток утечки, который направляется в пусковой орган.

Если параметр выше определенного уровня устройство отключает электрическую цепь посредством разделения силовых контактов дифавтомата.

Для проверки работоспособности предусмотрена специальная кнопка, чаще всего подписываемая, как «TEST». Она подключена через сопротивление, которое подключается двумя способами:

- Параллельно одной из существующих обмоток;

- Отдельной обмоткой на трансформатор.

После срабатывания кнопки пользователь искусственно формирует ток небаланса. Если дифавтомат исправен, он должен отключить цепь. В противном случае делаются выводы о неисправности аппарата.

Если дифавтомат исправен, он должен отключить цепь. В противном случае делаются выводы о неисправности аппарата.

Следующий элемент дифавтомата — электрический расцепитель. Конструктивно он имеет вид электрического магнита с сердечником.

Назначением элемента является воздействие на отключающий механизм. Срабатывание электромагнита происходит при увеличении нагрузочного тока выше установленного уровня.

Чаще всего это бывает при появлении КЗ в низковольтной сети. Особенность расцепителя заключается в срабатывании без выдержки времени. На отключение питания уходят доли секунды.

В отличие от электромагнитного, тепловой расцепитель защищает не от КЗ в цепи, а от перегрузок. В основе узла лежит биметаллическая пластинка, через которую протекает нагрузочный ток.

Если он выше допустимого значения (номинального тока дифавтомата), происходит постепенная деформация этого элемента. В определенный момент пластина из биметалла постепенно изгибается.

В определенный момент она воздействует на отключающий орган защитного устройства. Задержка времени теплового расцепителя зависит от тока и температуры в месте установки. Как правило, эта зависимость имеет прямо пропорциональный характер.

Задержка времени теплового расцепителя зависит от тока и температуры в месте установки. Как правило, эта зависимость имеет прямо пропорциональный характер.

На кожухе дифавтомата прописывается нижний предел (указывается в мА). Кроме тока утечки, указывается и номинальный ток расцепителя. Более подробно о маркировке аппарата поговорим ниже.

Как расшифровать обозначения на корпусе?

Выше уже отмечалось, что на корпусе дифференциального автомата можно найти всю необходимую информацию.

Изучив основные параметры, легче принимать решение — подходит ли прибор под решения конкретных задач.

К наиболее важным обозначениям стоит отнести:

- АВДТ — аббревиатура, сокращенный вариант полного названия («автоматический выключатель дифференциального тока»).

- С25 — номинальный параметр тока. Здесь C — характеристика зависимости времени и тока, а 25 — предельный ток дифавтомата, превышение которого недопустимо.

- 230 В — номинальное напряжение, при котором допускается применение аппарата (для бытовой сети).

- In 30mA — параметр тока утечки. При достижении 30 мА работает УЗО.

- Специальный знак, который подтверждает наличие функции УЗО и тип АВДТ. По наличию обозначения делается вывод о способности дифференциального автомата реагировать на постоянный или переменный пульсирующий ток.

Также на корпусе защитного изделия нанесена принципиальная схема. Обычному обывателю она может ничего не рассказать, поэтому на нее не обязательно обращать внимание.

Также на внешней части устройства предусмотрена кнопка «ТЕСТ», необходимая для периодического контроля исправности устройства в части УЗО. Об особенностях проверки с помощью этого элемента мы уже говорили выше.

Как подключить устройство?

Перед тем как подключить дифавтомат, стоит разобраться с типом электрической проводки.

Здесь возможны следующие варианты:

- Тип сети — однофазная или трехфазная. В первом случае номинальное напряжение составит 220 Вольт, а во втором — 380.

- Наличие заземления — существуют сети с заземлением или без него.

- Место для монтажа. Чаще всего АВДТ устанавливается в квартире, но возможен монтаж на каждую отдельную группу проводников.

С учетом рассмотренных условий необходимо определиться, как подключать защитный аппарат. Стоит помнить, что дифавтомат может иметь ряд конструктивных отличий.

Рассмотрим основные способы подключения в щитке:

- Простейший вариант. Популярный способ — установка одного дифференциального автомата, который защищает всю цепочку. При выборе такого варианта желательно покупать дифавтомат с большим номинальным током, чтобы учесть нагрузку всех потребителей в квартире. Главный минус схемы заключается в сложности поиска места повреждения при срабатывании защиты. По сути, проблема может скрываться на любом из участков проводки.В приведенной схеме видно, что «земля» идет отдельно и объединяется с шиной заземления. К ней же подключаются все проводники (PE) от электрических приборов. Ключевое значение имеет подключение «нуля», который выведен из дифавтомата.

Его объединение с другими «нулями» электрической сети запрещено. Это объясняется разницей величин токов, проходящих по каждому из нулевых проводников, из-за чего дифференциальный автомат может срабатывать.

Его объединение с другими «нулями» электрической сети запрещено. Это объясняется разницей величин токов, проходящих по каждому из нулевых проводников, из-за чего дифференциальный автомат может срабатывать. - Надежная защита. Это улучшенный вариант подключения защитного аппарата, благодаря применению которого удается повысить надежность сети и упростить задачу поиска повреждения. Особенность заключается в монтаже отдельного дифавтомата на каждую группу проводов. Следовательно, защитный аппарат будет работать только в той ситуации, когда проблема возникнет на контролируемом участке цепи. Другие участки продолжат работать в обычном режиме. В отличие от прошлой схемы, найти неисправность в случае КЗ, появления утечки или перегрузки в сети много проще. Но имеется и недостаток — большие финансовые затраты, связанные с необходимостью покупки нескольких дифавтоматов.

- Схема без заземления. Рассмотренные выше варианты подключения дифавтомата подразумевают наличие защитной «земли».

Но в некоторых домах или на дачном участке контур заземления отсутствует вовсе. В таких сетях применяется однофазная сеть, где присутствует только фаза и «ноль». В этой ситуации защитный аппарат (АВДП) подключается по другому принципу. Если у вас в низковольтной сети также нет «земли», перед установкой дифавтомата желательно полностью поменять проводку в доме. В противном случае в сети может быть ток утечки, из-за которого будет срабатывать УЗО.

Но в некоторых домах или на дачном участке контур заземления отсутствует вовсе. В таких сетях применяется однофазная сеть, где присутствует только фаза и «ноль». В этой ситуации защитный аппарат (АВДП) подключается по другому принципу. Если у вас в низковольтной сети также нет «земли», перед установкой дифавтомата желательно полностью поменять проводку в доме. В противном случае в сети может быть ток утечки, из-за которого будет срабатывать УЗО. - Схема для 3-х фазной сети. В случаях, когда требуется монтаж дифференциального аппарата в цепи тремя фазами (например, в современной квартире, в доме или в гараже), требуется соответствующий АВДП. Принципа построения здесь такой же, как и в прошлом случае. Разница в том, что на входе и на выходе нужно подключать четыре жилы.

По каким причинам может сработать дифавтомат?

В процессе эксплуатации защитного устройства важно понимать, в каких случаях оно может сработать.

С учетом этих нюансов стоит принимать решение о причине проблемы (короткое замыкание, ток утечки и прочие).

Рассмотрим каждый из вариантов более подробно:

Срабатывание без нагрузки.

В старых домах с плохой проводкой имеют место серьезные проблемы с изоляцией.

Последняя изношена и высок риск появления токов утечки, величина которых может меняться с учетом многих параметров — наличия рядом животных уровня влажности и так далее.

В такой ситуации АВДП может срабатывать ложно.

Причиной проблемы может быть:

- Поврежденная изоляция;

- Наличие скруток;

- Просчеты в расположении распредкоробок;

- Электрофурнитура.

Для выявления причины требуется ревизия проводки. Начинать необходимо с диагностики места повреждения.

Например, если дифавтомат выбивает при включении лампочки, проблему необходимо искать в осветительной цепи.

Если АВДП срабатывает после подключения какого-то либо устройства в розетку, стоит убедиться, что это устройство исправно.

При замыкании «нуля» и «земли».

Если по какой-либо причине провода N и PE касаются друг друга, высок риск срабатывания дифференциального автомата. Распространенные места замыканий — в распредкоробке или в коробе под розетку.

Распространенные места замыканий — в распредкоробке или в коробе под розетку.

Читайте по теме — эффективные способы защиты электроприборов с помощью специальных устройств.

Логика срабатывания построена на принципе действия устройства. Если «ноль» и «земля» объединены, ток разделяется между двумя проводниками. Соответственно, в дифтрансформаторе нет равенства токов, и он воспринимает этот факт, как утечку.

С проблемой часто сталкиваются начинающие мастера, которые не имеют должного опыта в вопросе обслуживания дифавтомата.

- В момент включения нагрузки. Если АВДП работает при подключении нагрузки, проблему необходимо искать в изоляции. Использовать проводку при такой неисправности небезопасно, поэтому рекомендуется вызвать специалиста и разобраться с проблемой. Если же ее игнорировать, высок риск попадания под напряжение кого-либо из членов семьи или возникновения пожара.

- При скачках напряжения. Логика дифавтомата построена таким образом, что отключение может происходить в случае повышения напряжения.

Правда, такой опцией обладают не все устройства, а только имеющие электронную схему. Кроме того, защита может работать при КЗ внутри потребителя, ведь дифавтомат умеет отключаться при таком виде аварии.

Правда, такой опцией обладают не все устройства, а только имеющие электронную схему. Кроме того, защита может работать при КЗ внутри потребителя, ведь дифавтомат умеет отключаться при таком виде аварии.

Читайте по теме — как действует электрический ток на организм человека.

Итоги

Дифференциальный автомат — полезное устройство, способное защитить от КЗ и токов утечки в низковольтной сети.

Для его правильного применения важно знать правила подключения и эксплуатации, а также особенности диагностики неисправности в случае срабатывания аппарата. Полезно почитать — как выполнять монтаж электропроводки в деревянном доме.

Что нужно сделать, чтобы проверить дифференциальный автомат и УЗО

Что нужно сделать, чтобы проверить дифференциальный автомат и УЗО

Большинству потребителей, абсолютно все равно, что перед ними: УЗО (устройство защитного отключения) или дифатомат (дифференциальный автомат). Но при разработке проектов электросети частных домов или квартир, данный вопрос имеет определенное значение.

Устройства защитного отключения выключатели дифференциального тока предназначены для отключения питания при возникновении тока утечки. Часто это называют дифференциальной защитой. Однако любой коммутационный аппарат необходимо проверять, как на срабатывание как таковое, так и на соответствие номинальным параметрам.

Принцип действия УЗО и дифавтомата и их отличия

Устройство защитного отключения ли как их называют «УЗО» срабатывают при разности токов между полюсами. Простым языком, принцип работы этих устройств заключается в сравнении тока через фазу и ноль.

Если ток через фазу больше чем через ноль, значит его часть потекла по другому пути, например, произошло повреждение изоляции проводников или ТЭН пробило и ток определенной величины «утекает» в землю.

Если корпус электроприбора заземлен — такая ситуация не слишком страшна и при хорошем заземлении даже не опасна, но если у вас в двух проводная электросеть без заземления — то на при попадании потенциала на корпус — он никуда с него не денется. В результате этого, ток потечет в землю через ваше тело, когда вы коснетесь корпуса оголенной частью тела.

В лучшем случае вы почувствуете пощипывания и одёрнете руку. В худшем случае величина тока через ваше тело может превысить допустимую и это приведет к смерти. УЗО бывают электромеханические и электронные, в сущности принцип работы у них одинаков, различается лишь система отработки отключения. В простейшем виде электромеханическое УЗО содержит трансформатор, с его помощью и сравнивается величина тока через один и другой полюс.

Чтобы отличить электронное УЗО от электромеханического, посмотрите на схему на его лицевой панели.

Важно: Устройство защитного отключения реагирует только на дифференциальный ток. Это значит, что УЗО не защищает электропроводку от токов короткого замыкания. От КЗ защищают автоматические выключатели. Дифавтомат — это комбинированное устройство, оно срабатывает и на повышенные токи, как автоматический выключатель, и на дифференциальный ток подобно УЗО. То есть в одном корпусе совмещены два коммутационных защитных аппарата.

Способы проверки

Как вы уже догадались — методика проверки срабатывания УЗО и дифавтомата на утечку аналогична. На лицевой панели и одного и другого прибора есть флажок включения/выключения и кнопка «ТЕСТ». Согласно ПТЭЭП прил. 3, табл. 28, п.28.7 нужно проверять срабатывание с помощью этой кнопки не реже чем раз в квартал (3 месяца).

Важно:

Кнопка «ТЕСТ» проверяет только срабатывание прибора по дифференциальному току или току утечки, но не проверяет срабатывание по превышению номинального тока у дифавтомата.

Есть 5 основных способов проверки:

— с помощью кнопки «ТЕСТ»;

— с помощью батарейки;

— с помощью магнита;

— резистором

— специализированным прибором.

Проверка с помощью кнопки «ТЕСТ»

При нажатии на кнопку проверки срабатывания УЗО или дифавтомата внутри прибора подключается резистор между выходящим фазным контактом и приходящим нулевым. Таким образом ток через фазный провод становится больше чем ток через нулевой провод. Если прибор исправен — он отключится. Следовательно, такая проверка возможна только если прибор подключен к электросети и на него подано питание.

Схема проверки УЗО или дифавтомата с помощью этой кнопки изображена на лицевой панели устройства.

Однако специалисты отзываются негативно о такой проверки, ссылаясь на то что рынок насыщен подделками и иногда встречаются такие экземпляры защитных приборов, в которых при нажатии на «ТЕСТ» прибор срабатывает даже если он не подключен к сети. Происходить этого недолжно.

Проверка с помощью батарейки и магнита

Рассмотрим, как проверить УЗО или дифавтомат в магазине не подключая прибор к электросети. Для этого нужна любая батарейка, подойдет и новая пальчиковая и два провода. Нужно подключить провода к батарейке, для этого можете воспользоваться элементарно изолентой, а вторые их концы соединить с клеммами одного из полюсов проверяемого прибора. При этом он должен быть взведен, то есть переведите флажок в положение «ВКЛ».

При этом нужно учесть тот факт, что УЗО или дифавтоматы устроены так, что срабатывают на одну из полуволн. Т.е. важна полярность при тестировании. Это значит, что, если при таком способе проверки прибор не защита не сработала — поменяйте полярность, для этого просто поменяйте провода местами. Если устройство не срабатывает ни при какой полярности – значит оно электронное, а не электромеханическое!

Примечание: УЗО типа «А» срабатывает при любой полярности, а типа «AC» — только при определенной полярности – переворачивайте батарейку!

С помощью магнита также можно определить исправность УЗО или дифавтомата прямо в магазине. Но такой способ работает только для электромагнитных выключателей дифференциального тока, приборы с электронной начинкой срабатывать не будут.

Для этого нужно поднести магнит к одной из сторон проверяемого прибора. Флажок опять-таки должен быть во включенном состоянии (вверх). Магнитное поле магнита наведет ток в обмотке измерительного трансформатора, в результате чего защита сработает и устройство отключится.

ВАЖНО:

Повторюсь, если УЗО электронное – такая проверка не сработает! Для работы электронных УЗО и дифавтоматов нужно чтобы было подключено питание (фаза и ноль).

Проверка с помощью резистора или лампочки

Предыдущие варианты проверки отражали только работоспособность защиты и реакцию на разность тока как таковую. Вы не могли определить насколько корректно срабатывает прибор. В домашних условиях проверить ток срабатывания можно, хоть и не совсем точно.

Для начала рассчитайте номинал резистора под величину дифференциального тока срабатывания. Например, очень распространены УЗО с током срабатывания в 30 мА, значит условно представим, что в сети 220 вольт (реальные значение измеряйте непосредственно на объекте где будет установлен прибор). Значит нужно взять резистор на:

220/0.030=7333.33 Ом

Мощность на резисторе выделится кратковременно (порядка 6 Ватт), но тем не менее будет лучше если вы выберете как можно более мощный резистор.

После этого подключаем резистор между фазой, выходящей и нулем, приходящим к прибору, как показано на рисунке ниже.

Таким же образом и работает кнопка «ТЕСТ».

ВАЖНО:

При такой проверке УЗО должно быть подключено к сети.

Если прибор не отреагировал на подключение рассчитанного резистора — значит он бракованный. Также вы можете измерить ток с помощью мультиметра. Но так как его протекание будет кратковременным — вы можете не увидеть его величину. Для поверок можно собрать такой прибор, как на видео ниже, только его недостаток в том, что указывается расчетный ток.

Можно конечно измерить реальный ток срабатывания УЗО с помощью амперметра, но такая для этого нужен мощный реостат. Плавно уменьшая сопротивление и измеряя ток, вы сможете определить при каком токе произошло отключение. При этом лучше использовать стрелочные приборы, так как большинство бюджетных цифровых медленно обновляют показания измеряемой величины.

Заключение

Для точной проверки УЗО и дифавтоматов используют специальные приборы, например:

— Sonel MRP-200;

— ПЗО-500;

— ПЗО-500 Про.

Кроме тока утечки с помощью подобных устройств можно проверить приборы при различном угле фазы и измерить скорость срабатывания при различных токах утечки.

Покупать их для частного использования нецелесообразно, так как они дорогие. Монтируя электрощит на объекте, вы можете обратится для получения такой услуги в электролабораторию и отсеять бракованные приборы, если они есть.

Нормы: Согласно ПТЭЭП проверка выключателей дифференциального тока должна осуществляться в соответствии с рекомендациями завода изготовителя. В среднем они включают в себя проверку перемещения флажка «ВКЛ/ВЫКЛ». Он должен четко переключаться из одного положения в другое, а также 1 раз в указанный период проходить проверку нажатием кнопки «ТЕСТ» (но не реже 1 раза в квартал, согласно ПТЭЭП). Ток срабатывания должен быть не менее чем 0.5In (для УЗО на 30 мА — это 15 мА), другие допустимые величины описаны в ГОСТ Р50571.16-99.

Ранее ЭлектроВести писали, почему бьет током одежда, мебель, машина и окружающие предметы.

По материалам: electrik.info.

Дифференциальный автомат — это… Что такое Дифференциальный автомат?

Двухполюсное УЗО с номинальным током 100 А

Устройство защитного отключения (УЗО; более точное название: Устройство защитного отключения, управляемое дифференциальным (остаточным) током, сокр. УЗО−Д) — механический коммутационный аппарат или совокупность элементов, которые при достижении (превышении) дифференциальным током заданного значения при определённых условиях эксплуатации должны вызвать размыкание контактов. Может состоять из различных отдельных элементов, предназначенных для обнаружения, измерения (сравнения с заданной величиной) дифференциального тока и замыкания и размыкания электрической цепи (разъединителя)[1].

Основная задача УЗО — защита человека от поражения электрическим током и от возникновения пожара, вызванного утечкой тока через изношенную изоляцию проводов и некачественные соединения.

Широкое применение также получили комбинированные устройства, совмещающие в себе УЗО и устройство защиты от сверхтока, такие устройства называются УЗО−Д со встроенной защитой от сверхтоков, либо просто диффавтомат.

Назначение

УЗО предназначены для

- Защиты человека от поражения электрическим током при косвенном прикосновении (прикосновение человека к открытым проводящим нетоковедущим частям электроустановки, оказавшимся под напряжением в случае повреждения изоляции), а также при непосредственном прикосновении (прикосновение человека к токоведущим частям электроустановки, находящимся под напряжением). Данную функцию обеспечивают УЗО соответствующей чувствительности (ток отсечки не более 30 mA).

- Предотвращения возгораний при возникновении токов утечки на корпус или на землю.

Цели и принцип работы

схема УЗО и принцип работы

Принцип работы УЗО основан на измерении баланса токов между входящими в него токоведущими проводниками с помощью дифференциального трансформатора тока. Если баланс токов нарушен, то УЗО немедленно размыкает все входящие в него контактные группы, отключая таким образом неисправную нагрузку.

УЗО измеряет алгебраическую сумму токов, протекающих по контролируемым проводникам (двум для однофазного УЗО, четырем для трехфазного и т. д.): в нормальном состоянии ток, «втекающий» по одним проводникам, должен быть равен току, «вытекащему» по другим, то есть сумма токов, проходящих через УЗО равна нулю (точнее, сумма не должна превышать допустимое значение). Если же сумма превышает допустимое значение, то это означает, что часть тока проходит помимо УЗО, то есть контролируемая электрическая цепь неисправна — в ней имеет место утечка.

В США, в соответствии с National Electrical Code, устройства защитного отключения (ground fault circuit interrupter — GFCI), предназначенные для защиты людей, должны размыкать цепь при утечке тока 4-6 мА (точное значение выбирается производителем устройства и обычно составляет 5 мА) за время не более 25 мс. Для устройств GFCI, защищающих оборудование (то есть не для защиты людей), отключающий дифференциальный ток может составлять до 30 мА. В Европе используются УЗО с отключающим дифференциальным током 10-500 мА.

С точки зрения электробезопасности УЗО принципиально отличаются от устройств защиты от сверхтока (предохранителей) тем, что УЗО предназначены именно для защиты от поражения электрическим током, поскольку они срабатывают при утечках тока значительно меньших, чем предохранители (обычно от 2 ампер и более для бытовых предохранителей, что во много раз превышает смертельное для человека значение). УЗО должны срабатывать за время не более 25-40 мс, то есть до того, как электрический ток, проходящий через организм человека, вызовет фибрилляцию сердца — наиболее частую причину смерти при поражениях электрическим током.

Эти значения были установлены путем тестов, при которых добровольцы и животные подвергались воздействию электрического тока с известным напряжением и силой тока.

Обнаружение токов утечки при помощи УЗО является дополнительным защитным мероприятием, а не заменой защите от сверхтоков при помощи предохранителей, так как УЗО никак не реагирует на неисправности, если они не сопровождаются утечкой тока (например, короткое замыкание между фазным и нулевым проводниками).

УЗО с отключающим дифференциальным током порядка 300 мА и более иногда применяются для защиты больших участков электрических сетей (например, в компьютерных центрах), где низкий порог привел бы к ложным срабатываниям. Такие низкочувствительные УЗО выполняют противопожарную функцию и не являются эффективной защитой от поражения электрическим током.

Пример

Внутреннее устройство УЗО, подключаемого в разрыв шнура питания

На фотографии показано внутреннее устройство одного из типов УЗО. Данное УЗО предназначено для установки в разрыв шнура питания, его номинальный ток 13 А, отключающий дифференциальный ток 30 мА. Данное устройство является:

- УЗО со вспомогательным источником питания

- выполняющим автоматическое отключение при отказе вспомогательного источника

Это означает, что УЗО может быть включено только при наличии питающего напряжения, при пропадании напряжения оно автоматически отключается (такое поведение повышает безопасность устройства).

Фазный и нулевой проводники от источника питания подключаются к контактам (1), нагрузка УЗО подключается к контактам (2). Проводник защитного заземления (PE-проводник) к УЗО никак не подключается.

При нажатии кнопки (3) контакты (4) (а также еще один контакт, скрытый за узлом (5)) замыкаются, и УЗО пропускает ток. Соленоид (5) удерживает контакты в замкнутом состоянии после того, как кнопка отпущена.

Катушка (6) на тороидальном сердечнике является вторичной обмоткой дифференциального трансформатора тока, который окружает фазный и нулевой проводники. Проводники проходят сквозь тор, но не имеют электрического контакта с катушкой[2]. В нормальном состоянии ток, текущий по фазному проводнику, точно равен току, текущему по нулевому проводнику, однако эти токи противоположны по направлению. Таким образом, токи взаимно компенсируют друг друга и в катушке дифференциального трансформатора тока ЭДС отсутствует.

Любая утечка тока из защищаемой цепи на заземленные проводники (например, прикосновение человека, стоящего на мокром полу, к фазному проводнику) приводит к нарушению баланса в трансформаторе тока: через фазный проводник «втекает больше тока», чем возвращается по нулевому (часть тока утекает через тело человека, то есть помимо трансформатора). Несбалансированный ток в первичной обмотке трансформатора тока приводит к появлению ЭДС во вторичной обмотке. Эта ЭДС сразу же регистрируется следящим устройством (7), которое отключает питание соленоида (5). Отключенный соленоид больше не удерживает контакты (4) в замкнутом состоянии, и они размыкаются под действием силы пружины, обесточивая неисправную нагрузку.

Устройство спроектировано таким образом, что отключение происходит за доли секунды, что значительно снижает тяжесть последствий от поражения электрическим током.

Кнопка проверки (8) позволяет проверить работоспособность устройства путем пропускания небольшого тока через оранжевый тестовый провод (9). Тестовый провод проходит через сердечник трансформатора тока, поэтому ток в тестовом проводе эквивалентен нарушению баланса токонесущих проводников, то есть УЗО должно отключиться при нажатии на кнопку проверки. Если УЗО не отключилось, значит оно неисправно и должно быть заменено.

Применение

В России применение УЗО стало обязательным с принятием 7-го издания Правил устройства электроустановок (ПУЭ). Выдержки из документов, регламентирующих применение УЗО, собраны здесь. Как правило, в случае бытовой электропроводки одно или несколько УЗО устанавливаются на DIN-рейку в электрощите.

Многие производители бытовых устройств, которые могут быть использованы в сырых помещениях (например, фены), предусматривают для таких устройств встроенное УЗО. В ряде стран подобные встроенные УЗО являются обязательными.

Проверка

Рекомендуется ежемесячно проверять работоспособность УЗО. Наиболее простой способ проверки — нажатие кнопки «тест», которая обычно расположена на корпусе УЗО (как правило, на кнопке «тест» нанесено изображение большой буквы «Т»). Тест кнопкой может производиться пользователем, то есть квалифицированный персонал для этого не требуется. Если УЗО исправно и подключено к электрической сети, то оно при нажатии кнопки «тест» должно сразу же сработать (то есть отключить нагрузку). Если после нажатия кнопки нагрузка осталась под напряжением, то УЗО неисправно и должно быть заменено.

Тест нажатием кнопки не является полной проверкой УЗО. Оно может срабатывать от кнопки, но не пройти полный лабораторный тест, включающий измерение отключающего дифференциального тока и времени срабатывания.

Кроме того, нажатием кнопки проверяется само УЗО, но не правильность его подключения. Поэтому более надежной проверкой является имитация утечки непосредственно в цепи, которая является нагрузкой УЗО. Такой тест желательно проделать хотя бы один раз для каждого УЗО после его установки. В отличие от нажатия кнопки, пробная утечка должна проводиться только квалифицированным персоналом.

Ограничения

УЗО может значительно улучшить безопасность электроустановок, но оно не может полностью исключить риск поражения электрическим током или пожара. УЗО не реагирует на аварийные ситуации, если они не сопровождаются утечкой из защищаемой цепи. В частности, УЗО не реагирует на короткие замыкания между фазами и нейтралью.

УЗО также не сработает, если человек оказался под напряжением, но утечки при этом не возникло, например, при прикосновении пальцем одновременно и к фазному, и к нулевому проводникам. Предусмотреть электрическую защиту от таких прикосновений невозможно, так как нельзя отличить протекание тока через тело человека от нормального протекания тока в нагрузке. В подобных случаях действенны только механические защитные меры (изоляция, непроводящие кожухи и т. п.), а также отключение электроустановки перед ее обслуживанием.

История

В начале 1970-х годов большинство УЗО выпускались[3] в корпусах типа автоматических выключателей. С начала 1980-х годов большинство бытовых УЗО были уже встроенными в розетки. В России используются преимущественно УЗО для монтажа в электрощите на DIN-рейку, а встроенные УЗО пока широкого распространения не получили.

Классификация УЗО

По способу действия

- УЗО−Д без вспомогательного источника питания

- УЗО−Д со вспомогательным источником питания:

- выполняющие автоматическое отключение при отказе вспомогательного источника с выдержкой времени и без нее:

- производящие автоматическое повторное включение при восстановлении работы вспомогательного источника

- не производящие автоматическое повторное включение при восстановлении работы вспомогательного источника

- не производящие автоматическое отключение при отказе вспомогательного источника:

- способные произвести отключение при возникновении опасной ситуации после отказа вспомогательного источника

- не способные произвести отключение при возникновении опасной ситуации после отказа вспомогательного источника

- выполняющие автоматическое отключение при отказе вспомогательного источника с выдержкой времени и без нее:

По способу установки

- стационарные с монтажом стационарной электропроводкой

- переносные с монтажом гибкими проводами с удлинителями

По числу полюсов

- однополюсные двухпроводные

- двухполюсные

- двухполюсные трехпроводные

- трехполюсные

- трехполюсные четырехпроводные

- четырехполюсные

По виду защиты от сверхтоков и перегрузок по току

- без встроенной защиты от сверхтоков

- со встроенной защитой от сверхтоков

- со встроенной защитой от перегрузки

- со встроенной защитой от коротких замыканий

По потере чувствительности в случае двойного заземления нулевого рабочего проводника

На стадии рассмотрения

По возможности регулирования отключающего дифференциального тока

- нерегулируемые

- регулируемые:

- с дискретным регулированием

- с плавным регулированием

По стойкости при импульсном напряжении

- допускающие возможность отключения при импульсном напряжении

- стойкие при импульсном напряжении

По характеристикам наличия постоянной составляющей дифференциального тока

- УЗО−Д типа АС

- УЗО−Д типа А

- УЗО−Д типа В

Характеристики УЗО

Характеристики, общие для всех УЗО−Д

- Способ установки

- Число полюсов и число токоведущих проводников

- Номинальный ток In — указанное изготовителем значение тока, которое УЗО−Д может пропускать в продолжительном режиме работы

- Номинальный отключающий дифференциальный ток IΔn — указанное изготовителем значение дифференциального тока, которое вызывает отключение УЗО−Д при заданных условиях эксплуатации

- Номинальный неотключающий дифференциальный ток, если он отличается от предпочтительного значения IΔn0 — указанное изготовителем значение дифференциального тока, которое не вызывает отключения УЗО−Д при заданных условиях эксплуатации

- Тип УЗО−Д по характеристикам наличия постоянной составляющей дифференциального тока

- Номинальное напряжение Un — указанное изготовителем действующее значение напряжения, при котором обеспечивается работоспособность УЗО−Д (в частности при коротких замыканиях)

- Номинальная частота — значение частоты, на которое рассчитано УЗО−Д и при котором оно работоспособно при заданных условиях эксплуатации

- Тип вспомогательного источника (если он имеется) и реакция УЗО−Д на его отказ

- Номинальное напряжение вспомогательного источника (если он имеется) Usn — напряжение вспомогательного источника, на которое рассчитано УЗО−Д и при котором обеспечивается его работоспособность при заданных условиях эксплуатации

- Номинальная включающая и отключающая способность Im — действующее значение ожидаемого тока, который УЗО−Д способно включить, пропускать в течение своего времени и отключить при заданных условиях эксплуатации без нарушения его работоспособности

- Номинальная способность включения и отключения дифференциального тока IΔm — действующее значение ожидаемого дифференциального тока, который УЗО−Д способно включить, пропускать в течение своего времени отключения и отключить при заданных условиях эксплуатации без нарушения его работоспособности

- Выдержка времени (если она имеется)

- Селективность (если она имеется)

- Координация изоляции, включая воздушные зазоры и пути утечки тока

- Степень защиты (по ГОСТ 14254)

Только для УЗО−Д без встроенной защиты от коротких замыканий

- Вид защиты от коротких замыканий

- Номинальный условный ток короткого замыкания Inc — указанное изготовителем действующее значение ожидаемого тока, который способно выдержать УЗО−Д, защищаемое устройством защиты от коротких замыканий, при заданных условиях эксплуатации без необратимых изменений, нарушающих его работоспособность

- Номинальный условный дифференциальный ток при коротком замыкании IΔc — указанное изготовителем значение ожидаемого дифференциального тока, которое способно выдержать УЗО−Д, защищаемое устройством защиты от коротких замыканий, при заданных условиях эксплуатации без необратимых изменений, нарушающих его работоспособность

Смотри также

Примечания

- ↑ Определение согласно ГОСТ Р 50807-95 (2003)

- ↑ То есть катушка гальванически развязана от токонесущих проводников УЗО

- ↑ За рубежом. В России УЗО начали применяться гораздо позже — примерно с 1994—1995 годов

Ссылки

Wikimedia Foundation. 2010.

Дифференциальный автомат. Виды и работа. Устройство

Рассмотрим один из видов защиты – автомат дифференциального тока, или дифференциальный автомат. Это устройство включает в себя функции устройства защитного отключения и автоматического выключателя. Оно обеспечивает защиту контролируемой цепи от токов короткого замыкания и перегрузочных токов, работая в качестве автоматического выключателя. Также дифференциальный автомат защищает человека от возможного удара электрическим током в результате токов утечки, не допускает пожара вследствие повреждения изоляции токоведущих элементов электроустановки, выполняя при этом функции УЗО.

Дифференциальный автомат

Разделение дифавтоматов на виды осуществляется по их характеристикам.

Тип электрической сетиВсе устройства защиты выбирают по числу фаз электрической сети. Существуют дифференциальные автоматы для эксплуатации в однофазной сети 220 вольт, для трехфазной сети 380 вольт. На корпусе устройства есть соответствующее обозначение. Трехфазные модели оснащены нулевым полюсом и тремя полюсами фаз. Его размеры значительно больше, в отличие от однофазной модели, на которой имеется полюс фазы и ноля. На первой картинке слева – однофазный автомат, справа – трехфазный.

Параметры токаНоминальный ток обозначается буквой «С» рядом с числом нагрузки тока в амперах.

В быту популярными стали дифавтоматы С16. Остальные виды используются реже. Ток утечки обозначается символом Δ, а справа от этого символа указывается ток в миллиамперах. В цепях освещения чаще всего используются дифавтоматы с номинальным значением тока утечки 10-30 мА. Из них для одиночных сетей применяют автоматы на 10 мА, а в групповых сетях на 30 мА. Защита с номинальным током утечки 100-300 мА применяется для входных дифавтоматов.

Многие потребители в момент запуска расходуют намного больше энергии, чем при дальнейшей работе. Такие токи называют пусковыми. Они во много раз могут превосходить эксплуатационные токи.

Для того, чтобы не прекращалась подача электроэнергии при запуске мощного электродвигателя, дифференциальный автомат работает так, что отключение выполняется только при значительном превышении его номинального тока.

По параметру тока, при котором срабатывает защита при запуске мощных потребителей, дифференциальные автоматы делятся на типы:

- В – выдерживает перегрузку от 3 до 5 раз.

- С – перегрузка от 5 до 10 раз.

- D – отключение питания происходит при возрастании тока от 10 до 20 раз.

Если к сети питания подключено малое количество устройств с небольшой мощностью, то лучше всего подходит тип В. В городских квартирах и домах рекомендуется подключать дифференциальные автоматы типа С. На промышленных производствах, оснащенных силовым оборудованием, устанавливают защиту типа D. Тип защиты обозначается рядом с током номинала на корпусе автомата.

Класс защитыЭтот параметр означает, на какие виды токов реагирует дифференциальный автомат.

AC — Для синусоидального переменного тока

A — Для синусоидального переменного и пульсирующего постоянного

B — Для переменного, импульсного, постоянного и сглаженного постоянного

S — Выдержка времени отключения 200-300 мс

G — Выдержка времени отключения 60-80 мс

В квартирах и собственных домах чаще всего применяются типы защит АС и А. Из них наиболее распространена защита А-класса, так как основная часть устройств потребителей оснащена электронным управлением. Например, светодиодная подсветка и некоторые виды люстр управляются с помощью электроники. АС-класс устанавливают в загородных дачах и домах, не имеющих электронных устройств.

Класс ограничения тока и отключающей способностиДифференциальный автомат имеет класс токоограничения, по которому можно определить быстродействие обесточивания линии питания при появлении критических значений тока.

Класс токоограничения имеет цифровое обозначение:

- 1 – медленный.

- 2 – средний.

- 3 – быстрый.

С повышением класса возрастает и стоимость дифавтомата. В прямоугольнике изображена отключающая способность, а класс токоограничения под ней в квадратике.

Условия эксплуатацииОсновная часть дифавтоматов эксплуатируется в теплых отапливаемых помещениях, и рассчитана на работу в диапазоне -5 +35 градусов. Если дифференциальный автомат необходимо установить вне помещения, то применяют другой тип автоматов, так как в зимнее время температура может опуститься до более низких значений. Для таких случаев существуют морозоустойчивые автоматы, способные работать при более низких температурах.

На корпусе таких автоматов имеется специальный значок снежинки.

При всех аналогичных характеристиках морозоусточивые модели имеют стоимость выше, по сравнению с другими моделями.

Внутреннее устройствоКонструкция дифавтомата может быть электронной или электромеханической. Электронные модели получают питание от фазного провода. При отсутствии электроэнергии такие дифавтоматы не способны выполнять свои функции. Поэтому наиболее надежными считаются электромеханические автоматы, которые для работы не нуждаются в отдельном источнике электроэнергии, и могут работать в любой ситуации.

Чтобы самостоятельно проверить тип дифавтомата, понадобится простая батарейка и два куска провода. Один отрезок провода необходимо подключить к одному полюсу батарейки, а второй проводник ко второму полюсу.

Далее, включаем автомат и оголенными концами проводников касаемся контактов автомата вверху и внизу, создавая эффект замыкания и утечки тока. Если защита сработала, то дифавтомат является электромеханическим, так как он способен функционировать и выполнять свои задачи без внешнего питания.

Устройство и принцип работыДифференциальный автомат состоит из защитной и рабочей части. Защитная часть автомата представляет собой модуль дифзащиты, который отвечает за ток утечки на землю (дифференциальный ток). Также, в модуле происходит преобразование электрического тока в механическое воздействие на специальную рейку, которая выключает питание. Этот механизм и является рабочей частью дифавтомата.

Модуль защиты обеспечивается питанием путем последовательного подключения с автоматическим выключателем. Модуль защиты оснащен вспомогательными устройствами, такими как электронный усилитель, с обмоткой электромагнитного сброса, а также дифференциальный трансформатор, который выявляет остаточный ток.

Чтобы проверить работоспособность модуля защиты, корпус дифавтомата оснащен кнопкой «Тест». Если нажать на эту кнопку, то происходит имитация тока утечки, и при исправном автомате питание должно отключиться.

В дифавтомате в качестве датчика дифференциального тока используется специальный трансформатор, так же как и в устройстве защитного отключения. Действие этого трансформатора заключается в преобразовании тока утечки в проводах, которые подают электроэнергию на устройство защиты.

Если нет неисправностей изоляции проводов, либо к токоведущим элементам никто не прикоснулся, то тока утечки нет. При этом в проводниках фазы и ноля протекают одинаковые токи.

Такими токами наводятся одинаковые магнитные потоки, направленные навстречу друг другу, в магнитопроводе трансформатора. В итоге во вторичной обмотке ток равен нулю, а магнитоэлектрическая защелка, являющаяся чувствительным элементом, не срабатывает.

При появлении утечки тока, например, если кто-то прикоснулся к проводу фазы, либо повредилась изоляция, нарушается баланс магнитных потоков и тока.

В это время во вторичной обмотке появляется электрический ток, приводящий в движение магнитоэлектрическую защелку, которая действует на расцепляющий механизм автомата и систему контактов.

Похожие темы:

Автоматическое дифференцирование и двойное число в прямом режиме | Роберт Ланге

Автоматическая дифференциация (AD) — одна из движущих сил истории успеха глубокого обучения. Это позволяет нам эффективно вычислять оценки градиента для наших любимых составных функций. TensorFlow, PyTorch и все предшественники используют AD. Наряду с методами стохастической аппроксимации, такими как SGD (и все его варианты), эти градиенты уточняют параметры наших любимых сетевых архитектур.

Многие люди (до недавнего времени включая меня) считают, что обратное распространение, правило цепочки и автоматическое дифференцирование являются синонимами. Но это не так. Чтобы стать настоящими мастерами своего дела, мы должны понять, почему. 🔥

TL; DR : Мы обсуждаем различные способы дифференциации компьютерных программ. В частности, мы сравниваем автоматическое дифференцирование в прямом и обратном (обратном) режимах. В конечном итоге мы реализуем AD прямого режима с двойными числами для решения простой задачи логистической регрессии.Обычный цифровой код можно найти здесь .

Термин «дифференцируемое программирование» может немного ошеломить. В целом программы не имеют ничего общего с анализом или дифференцируемыми функциями. За исключением компьютерных функций, которые оценивают математические функции. Представьте, что вы столкнулись с задачей подобрать модель логистической регрессии. Один из способов сделать это — итеративно минимизировать двоичную кросс-энтропийную потерю вашей функции логистического вывода с учетом некоторых истинно помеченных данных:

Аналитическое выражение можно легко преобразовать в некоторый код Python:

Функция вычисляет числовое значение на основе фиксированные истинные метки ( y_true ) и предсказанные / подогнанные вероятности меток ( y_pred ).В нашем случае y_pred составляет выходной сигнал со сжатием сигмовидной формы, который снова является функцией β. Чтобы найти наиболее подходящие коэффициенты, нам нужно следовать направлению наискорейшего спуска (также известного как градиент), которое минимизирует функцию потерь. Для этого у нас есть доступ к набору методов дифференциации:

- Ручная дифференциация (🙌): Как уже можно заметить, ручная дифференциация требует, чтобы производная была определена на листе бумаги. Впоследствии эту производную можно реализовать в коде.Это чревато «математическими» ошибками и (по крайней мере, для меня) отнимает довольно много времени. Удачи в попытках разобраться в глубокой сети.

- Числовое дифференцирование (💻): Вместо того, чтобы запачкать руки правилами цепочки и частного, можно просто попытаться аппроксимировать градиент, используя два бесконечно малых разных входа. Тем самым мы приближаем формальное определение производной. Это имеет два основных недостатка: требует многократных оценок функций (по крайней мере, дважды для каждого входного измерения) и подвержен ошибкам округления, а также ошибкам усечения (входные данные никогда не бывают одинаковыми).С другой стороны, это очень легко реализовать.

- Символьное дифференцирование (🈂): Символьные методы применяют преобразования, которые соответствуют правилам дифференцирования, чтобы получить выражение для производной. Это реализовано в программном обеспечении, таком как Mathematica, и требует серьезных алгебраических манипуляций. Составление функций рискует привести к чрезмерно сложным символическим представлениям производной. Это обычно называют «вздутие живота».В конечном итоге это может привести к произвольно дорогостоящим оценкам градиента.

- Автоматическое дифференцирование (🔁): вместо увеличения до бесконечности AD упрощает выражение производной в любой возможный момент времени. Например после каждой операции! Всю математику можно рассматривать как композицию конечного набора основных операций (сложение, умножение, возведение в степень и т. Д.). И для таких операций мы уже знаем функциональную форму производной. Благодаря красоте правила цепочки мы можем объединить эти элементарные производные и уменьшить сложность выражения за счет хранения в памяти.

По своей сути AD объединяет в себе лучшее, что есть как в числовом, так и в символическом мире. Он вычисляет значение производной с помощью набора элементарных правил от символического дифференцирования. Чтобы преодолеть опухоль, символическое выражение упрощается на каждом этапе. Просто численно оценивая результаты предыдущих вычислений (или просто входные данные). Следовательно, он не дает аналитического выражения для самой производной. Вместо этого он итеративно оценивает данные градиента.Проще говоря: f ’(2) ≠ f’ (x).

Давайте посмотрим, как это применимо к нашей задаче логистической регрессии, и определим пошаговые результаты как a (h) = σ (h) и h (X, β) = X β. Затем мы можем переписать интересующий градиент как:

Выражение, приведенное выше, получено вручную. На первый взгляд это может не выглядеть упрощением. Но теперь мы можем наблюдать более общий принцип: градиент можно разложить на компоненты градиента отдельного пути преобразования:

- Предварительные активации h (X, β) и их градиент ∇h (X, β) относительно параметров β .

- Активации a (h) и их градиент ∇a (h) относительно предварительных активаций h.

- Журнал вероятностей класса log a (h) и диагональная матрица градиента ∇log a (h) относительно активаций a.

Для каждого из частных оценок h (X, β), a (h), log a (h) мы можем легко вычислить чувствительность к их соответствующим входным данным β, h, a и получить их производные. В конечном итоге истинный вектор вероятности p обеспечивает сигнал ошибки, который масштабирует градиент.

Мы можем перейти к автоматически. вычислить отдельные компоненты градиента двумя разными способами:

- Накопительный режим в прямом направлении (⏩): Режим простого выдвижения применяет правило цепочки Лейбница к каждой базовой операции в прямом первичном преобразовании . трассировка .Таким образом, получается производная трасса . На каждом этапе мы оцениваем оператора, а также его градиент «синхронно»!

- Первичный след: h (X, β) → a (h) → log a (h)

- Производный след: ∇h (X, β) → ∇a (h) → ∇log a (h)

- Оценка Lockstep + производная:

Наконец, общий градиент ∇ L затем получается путем умножения отдельных частей вместе и изменения масштаба с p.

- Обратный накопительный режим (⏪): Обратный режим, с другой стороны, не вычисляет производные одновременно, а требует двух отдельных фаз.Во время прямой фазы все промежуточные переменные оцениваются и их значения сохраняются в памяти. В следующей обратной фазе мы затем распространяем обратно производные / сопряженные с помощью снова цепного правила. Обратный режим AD — это то, что мы обычно называем обратным распространением (Rumelhart et al., 1988) в глубоком обучении.

- Прямая фаза: h (X, β) → a (h) → log a (h)

- Обратная фаза: ∇log a (h) → ∇a (h) → ∇h (X, β). Итак, как мы узнаем, как отправить градиент? Нам нужна схема бухгалтерского учета, которая обеспечивается заранее заданным вычислительным графом , который определяет поток операций.

При сравнении режимов работы необходимо учитывать два основных момента:

- Хранение в памяти и время вычисления : в прямом режиме мы должны хранить производные, в то время как в обратном режиме AD требуется только сохранение активаций. В то время как в прямом режиме AD вычисляет производную одновременно с оценкой переменной, обратное распространение делает это в отдельной обратной фазе.

- Размерность входа и выхода : Учитывая функцию f, мы можем различать два режима в зависимости от размеров, которые будут обрабатываться:

- n << m: Размер входа меньше, чем выходной.Применяемые операции расширяют размерность с набора нескольких единиц. → Прямой режим в вычислительном отношении дешевле, чем обратный режим.

- n >> m: входной размер больше выходного. Это классическая установка глубокого обучения. Мы получаем скалярную оценку потерь от прямого прохода и возвращаемся к входу довольно большой размерности. → Обратный режим вычислительно дешевле, чем прямой режим.

Мы заинтересованы в продвижении вычислений от нескольких единиц ко многим.Вещи не обязательно должны быть такими четкими, поскольку можно довольно легко векторизовать вычисления в прямом режиме. Следовательно, никаких отдельных проходов вперед не требуется. Я предполагаю, что преобладание реверсивного режима в DL в основном связано с уменьшением требований к памяти.

Итак, здесь идет алгебраический магический трюк, который упрощает прямой режим AD: можно показать, что прямой режим AD эквивалентен оценке интересующей функции с двойными числами.

Моя мотивация для этого сообщения в блоге возникла из-за того, что я не был удовлетворен своим пониманием именно этой эквивалентности.Так что пришлось копнуть немного глубже. Позвольте мне теперь пролить свет на элегантность использования двойной части любой числовой оценки для вычисления соответствующих градиентов параметров. Так что же снова за двойные числа? Мы можем разложить входную переменную x на действительную и на двойную часть:

с вещественными числами v, v̇, ≠ 0 и ϵ² = 0. На основе этого простого определения получаются следующие основные арифметические свойства:

Кроме того, одно можно алгебраически вывести следующее:

Вау! Оценивая f (x) в двойственной форме и устанавливая v̇ = 1, мы можем восстановить как значение функции f (v), так и ее вычисленную производную f ’(v) в виде коэффициента перед! Наконец, цепное правило плавно переводится в двойную настройку:

Это означает, что мы можем легко распространять градиенты по уровням вычислений, просто умножая производные друг на друга.Для реализации двойных чисел нам просто нужна отдельная система хранения, которая отслеживает x = (v, coeff-in-front-of-v̇) и применяет соответствующие вычисления производной к двойственной части x. Потрясающая алгебра!

Для многомерных функций все становится немного сложнее. Представьте себе два входа:

Частная производная по x вычисляется путем задания v = 1 и u = 0. Для y мы должны перевернуть оба бита. Чтобы сделать это параллельно и предотвратить несколько прямых проходов, мы можем векторизовать вещи и сохранить диагональную матрицу:

, где каждая строка представляет одну частную производную.Все вышеперечисленные правила затем легко переводятся в многомерный случай.

Так что осталось обсудить, как думать о ϵ? Две интуиции, которые я позаимствовал из этого сообщения в блоге, следующие:

- ϵ можно рассматривать как форму бесконечно малого числа. Возводя в квадрат такое маленькое число, оно просто становится непредставимым. Интуитивно это похоже на размер шага численного дифференцирования.

- Другой возможный способ представить ϵ — это матрица:

Вычисление ϵ x ϵ затем дает требуемую нулевую матрицу.Ограничивая мнимые числа i² = -1, помогите нам в вычислении вращения. С другой стороны, двойные числа ограничивают ϵ² = 0 и позволяют проводить эффективную и точную оценку производной. Давайте посмотрим, как мы можем преобразовать это в код для нашего примера логистической регрессии.

Во-первых, нам нужны синтетические данные для нашей задачи двоичной классификации. Приведенный ниже объект класса генерирует коэффициенты, гауссовский шум и функции. После этого мы берем скалярное произведение и пороговое значение преобразованных функций, чтобы получить двоичные метки.Кроме того, есть несколько небольших утилит для выборки пакетов данных и перетасовки данных между эпохами. Все довольно стандартно. Ничего двойного.

Давайте сгенерируем данные!Теперь давайте определим «двойное мясо» вещей. Нам нужно убедиться, что все наши элементарные операции (сложение, умножение, активация сигмоида, а также логарифм, необходимый для градиента) действуют как на действительную, так и на двойную часть двойного представления вектора (для которого требуется градиент ). Следовательно, нам нужна двойная оболочка и перегрузка / переопределение операторов.

Давайте настроим несколько операций с двойными числами.Двойная версия сигмоидной функции применяет стандарт σ к действительной части и изменяет числовое значение двойной матрицы размерности n x d на ее вычисленную производную. Поскольку σ ’(h) = σ (h), (1 — σ) применяется к каждому элементу вектора h. Следовательно, общее изменение двойственной части дается формулой:

, что снова приводит к якобиану размера n x d. То же понятие переносится и на оператор журнала. Теперь, когда мы переопределили арифметические настройки для наших операций с двойными числами, давайте исследуем, как мы можем получить наши прогнозы логистической регрессии и соответствующие потери двоичной кросс-энтропии:

Простой проход «вперед» и оценка функции двойных потерьНаконец, давайте положим все вместе в последнем цикле обучения.Мы генерируем двоичные данные и инициализируем некоторые списки заполнителей для хранения наших промежуточных результатов. После этого мы вычисляем коэффициенты решения Sklearn, чтобы измерить, как далеко мы находимся. Затем мы можем просто перебрать отдельные партии. Мы инициализируем коэффициенты как двойной тензор, образцы пакетов, устанавливаем коэффициенты градиента / диагональную матрицу обратно в их инициализацию частной производной. Получаем прогнозы и проигрыш. Двойная оценка потерь соответствует интересующему градиенту ∇ L .Затем обновления SGD просто берут дуал и делают шаг в направлении наискорейшего спуска.

Давайте обучим простой пример и посмотрим на показатели:

Запустите цикл обучения!И какой сюрприз получается, что теория. Потери уменьшаются с увеличением количества обработанных пакетов. Коэффициенты сходятся к решению Sklearn и точности обучения небесным ракетам. Ганнибал из A-Team сказал: «Мне нравится, когда план слагается».

Мы уже обсуждали, почему обратное распространение и обратный режим AD более эффективны для стандартных приложений глубокого обучения.Одна из причин, по которой AD в прямом режиме все еще может пригодиться, — это его полезность при вычислении произведений вектора Гессе, Hv. Мы можем использовать конфигурацию назад-вперед-вперед , чтобы объединить как прямой, так и обратный режим для вычисления гессиана 2-го порядка. Более конкретно, учитывая функцию f со входом x, мы можем просто использовать оба режима вместе:

- Прямой режим: вычислить произведение вектора градиента ∇ fv , установив ẋ = v.

- Обратный режим: возьмите результат и примените обратное распространение к нему: ∇²fv = Hv

Смарт, да? Затем гессиан можно использовать для оптимизации более высокого порядка, которая также учитывает приблизительную кривизну поверхности потерь.В заключение: есть еще некоторая любовь к прямому режиму AD.

Мы увидели как мощность, так и ограничения автоматического дифференцирования прямого режима. Это позволяет нам одновременно оценивать функцию и ее производную. Таким образом, можно преодолеть двухфазную доктрину обратного режима AD, также известного как backprop. Это происходит за счет хранения двойных представлений всех промежуточных узлов. Кроме того, вычислительные усилия отдельного обратного прохода переносятся на прямой проход.Мы увидели, как магические алгебраические свойства двойственных чисел позволяют нам делать это эффективно и точно.

В целом, я нашел чрезвычайно приятным и очень полезным реализовывать что-то с нуля. Я совершенно по-другому думаю о текущих библиотеках DL, а также об их проблемах (например, статические и динамические вычислительные графы, хранение и вычисления). Я рекомендую заинтересованному читателю внимательнее ознакомиться с отличным обзором Baydin et al. (2018). Этот документ был моей отправной точкой и дает очень читаемый обзор! Также вы можете найти весь код здесь.

- Байдин А.Г., Б.А. Перлмуттер, А.А. Радул и Дж. М. Сискинд. (2018): «Автоматическая дифференциация в машинном обучении: обзор», Журнал исследований в области машинного обучения , 18.

- Рамелхарт, Д. Э., Г. Э. Хинтон, Р. Дж. Уильямс и другие. (1988): «Изучение представлений путем обратного распространения ошибок», Когнитивное моделирование , 5, 1.

Введение в градиенты и автоматическое дифференцирование

Автоматическая дифференциация и градиенты

Автоматическая дифференциация полезен для реализации алгоритмов машинного обучения, таких как обратное распространение для обучения нейронные сети.

В этом руководстве вы изучите способы вычисления градиентов с помощью TensorFlow, особенно при активном выполнении.

Настройка

импортировать numpy как np

импортировать matplotlib.pyplot как plt

импортировать тензорный поток как tf

Вычислительные градиенты

Чтобы различать автоматически, TensorFlow должен помнить, какие операции в каком порядке выполняются во время прохода вперед . Затем во время обратного прохода TensorFlow просматривает этот список операций в обратном порядке для вычисления градиентов.

Градиентные ленты

TensorFlow предоставляет tf.GradientTape API для автоматического различения; то есть вычисление градиента вычисления относительно некоторых входных данных, обычно tf. Переменная s.

TensorFlow «записывает» соответствующие операции, выполняемые в контексте tf.GradientTape , на «ленту». Затем TensorFlow использует эту ленту для вычисления градиентов «записанного» вычисления с использованием обратного дифференцирования.

Вот простой пример:

x = tf.Переменная (3,0)

с tf.GradientTape () в качестве ленты:

у = х ** 2

После того, как вы записали некоторые операции, используйте GradientTape.gradient (target, sources) для вычисления градиента некоторой цели (часто потери) относительно некоторого источника (часто переменных модели):

# dy = 2x * dx

dy_dx = tape.gradient (y, x)

dy_dx.numpy ()

6.0

В приведенном выше примере используются скаляры, но tf.GradientTape так же легко работает с любым тензором:

w = tf.Переменная (tf.random.normal ((3, 2)), name = 'w')

b = tf.Variable (tf.zeros (2, dtype = tf.float32), name = 'b')

x = [[1., 2., 3.]]

с tf.GradientTape (persistent = True) в качестве ленты:

у = х @ ш + Ь

потеря = tf.reduce_mean (y ** 2)